Tecnologia Científica

Redes neurais jogando videogame nos ensinam sobre nossos pra³prios cérebros

Um novo estudo da Caltech compara varreduras cerebrais de humanos jogando videogames cla¡ssicos da Atari a redes sofisticadas de inteligaªncia artificial (IA) que foram treinadas para jogar os mesmos jogos.

Reprodução

Quando vocêestãodirigindo, seu cérebro recebe uma enorme quantidade de informações visuais e as usa para tomar decisaµes de direção, como quando frear ou mudar de faixa. O cérebro precisa determinar que tipo de informação em seu campo de visão énecessa¡ria para tomar essas decisaµes. Por exemplo, a posição de outro carro émuito importante, mas uma nuvem no canãu ou a cor desse carro não tem realmente um impacto na maneira como vocêdirige.

Este éum exemplo dia¡rio de tomada de decisão em um ambiente natural complexo. O que o cérebro estãofazendo nessas situações em que háum grande volume de dados sensoriais e a necessidade de tomar decisaµes rapidamente? Para estudar esta e outras questões relacionadas, os pesquisadores podem fazer experiências usando simulações da nossa vida cotidiana: videogames.

Um novo estudo da Caltech compara varreduras cerebrais de humanos jogando videogames cla¡ssicos da Atari a redes sofisticadas de inteligaªncia artificial (IA) que foram treinadas para jogar os mesmos jogos. Liderados pelo estudante de graduação Logan Cross, os pesquisadores compararam o comportamento da IA ​​treinada com o dos humanos e descobriram que a atividade nos "neura´nios" artificiais da IA ​​parecia bastante semelhante a atividade no cérebro humano. Isso implica que o agente de IA pode resolver essas tarefas de tomada de decisão de maneira semelhante ao cérebro humano, tornando-o um bom modelo para estudar como o cérebro humano mapeia a entrada visual de alta dimensão em ações em ambientes complexos.

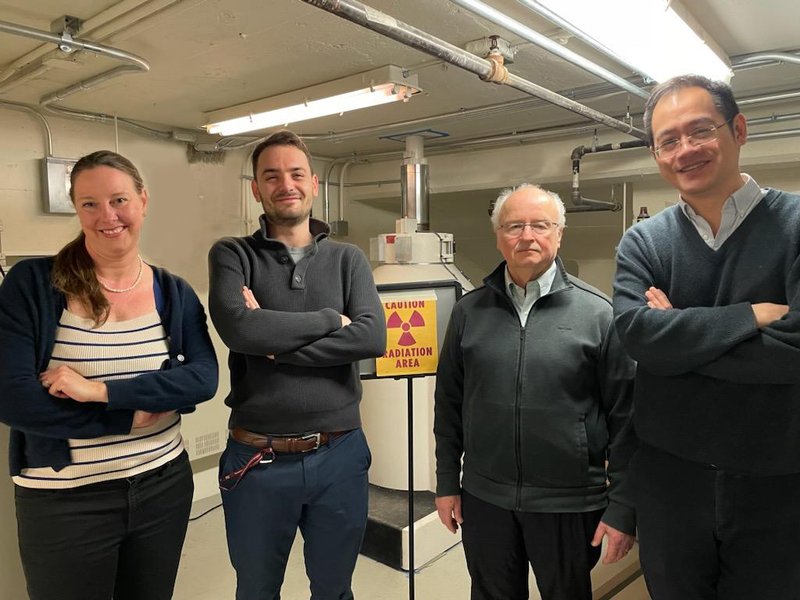

O estudo foi realizado no laboratório do professor de psicologia John O'Doherty . Um artigo descrevendo a pesquisa apareceu na revista Neuron em 15 de dezembro. O'Doherty éum membro do corpo docente afiliado do Tianqiao e Chrissy Chen Institute for Neuroscience da Caltech .

"A interação entre IA e Neurociênciaocorre em ambos os sentidos", diz O'Doherty. "Se pudermos descobrir como os algoritmos de IA são semelhantes ao cérebro, isso nos ajudara¡ a entender melhor como o cérebro resolve esses tipos de problemas difaceis, mas, inversamente, se pudermos entender por que e como o cérebro pode resolver esses jogos com muito mais eficiência em comparação com uma IA, isso pode ajudar a orientar o desenvolvimento de algoritmos de IA mais inteligentes e mais humanos no futuro. "

No campo da Neurociênciade decisão, que examina a maneira como a atividade neural no cérebro da¡ origem a tomada de decisaµes, muitos estudos usam tarefas simples para examinar como os humanos tomam decisaµes. Por exemplo, um participante do estudo pode ser solicitado a jogar em duas ma¡quinas caça-naqueis com pagamentos diferentes. Ao longo do experimento, o participante aprendera¡ qual ma¡quina caça-naqueis ganha mais dinheiro e ajustara¡ seu comportamento de acordo. A estrutura geral de aprendizagem para resolver essas tarefas échamada de aprendizagem por reforço porque o comportamento éreforçado pelos resultados gratificantes que resultam das decisaµes.

No entanto, a estrutura de aprendizado por reforço sozinha não descreve adequadamente a tomada de decisão em tarefas maiores e mais complicadas. Em 2015, a DeepMind, uma empresa de inteligaªncia artificial de propriedade do Google, desenvolveu um algoritmo de inteligaªncia artificial complexo, chamado Deep Q Network (DQN), que pode aprender a jogar dezenas de videogames Atari em naveis humanos ou sobre-humanos.

O DQN combina a estrutura cla¡ssica de aprendizagem por reforço com outro avanço recente chamado rede neural convolucional. A rede neural convolucional atua como um sistema perceptivo que aprende a detectar recursos visuais no espaço de pixels do Atari (a tela do jogo) que são preditivos de recompensa (pontos de pontuação). Isso permite que o DQN aprenda quais ações executar em uma determinada situação apenas observando os pixels no jogo. a‰ importante ressaltar que as regras do jogo não são programadas no agente DQN; ele deve aprender por si mesmo como o jogo éjogado por tentativa e erro, já que boas decisaµes são positivamente reforçadas quando o agente marca pontos (junto com as ações que levaram a pontuação).

Neste estudo, o DQN foi treinado nos videogames Atari Pong , Space Invaders e Enduro (um jogo de corrida) e, em seguida, seus neura´nios artificiais foram usados ​​para prever o comportamento e a atividade cerebral a partir de imagens de ressonância magnanãtica funcional do cérebro de participantes humanos como eles jogaram os jogos. Em particular, os pesquisadores descobriram que a atividade cerebral em duas regiaµes cerebrais envolvidas na percepção e na visão, a via visual dorsal e o cortex parietal posterior, podem ser modeladas usando recursos DQN.

Em todos os jogos, o DQN deve aprender como escolher os recursos relevantes de um grande volume de entrada visual, assim como um humano faria. Ele deve formatar essas informações relevantes no que échamado de espaço de estados, que éuma forma compacta de representar o que estãoacontecendo no estado atual do jogo. Por exemplo, em Pong , os pesquisadores descobriram que o espaço de estado nos ca³digos DQN para as posições espaciais da bola e das pa¡s; ele ignora recursos como as cores do fundo e a pontuação do jogo na parte superior da tela. Isso émuito semelhante a como o cérebro humano representa o jogo na via visual dorsal - a parte do cérebro que reconhece onde os objetos estãono espaço para guiar as ações relacionadas a esses objetos.

No jogo Enduro , o jogador dirige o mais rápido possível e tenta evitar outros carros. Durante a viagem, o canãu muda de cor do dia para a noite. a‰ fa¡cil para uma pessoa ignorar esses parametros, pois eles são irrelevantes para o jogo em si, da mesma forma que aprendemos a ignorar as nuvens no canãu ao dirigir um carro. Mas uma rede de IA deve aprender que a mudança de cor do canãu não tem impacto na direção.

Os pesquisadores descobriram que as caracteristicas do DQN que ignoram essas caracteristicas visuais irrelevantes explicam melhor os padraµes de atividade cerebral vistos no cortex parietal posterior dos voluntários que jogam, a parte do cérebro que conecta a percepção ao movimento motor. Resultados semelhantes também foram encontrados em Space Invaders .

Embora os pesquisadores tenham encontrado semelhanças entre o DQN e o cérebro humano, os dois não são idaªnticos.

“Demora dias de jogo sem parar para DQN aprender a jogar esses jogos, mas os humanos podem aprender em minutos,†diz Cross. "Por que éfa¡cil para o cérebro humano descobrir quais são as caracteristicas relevantes ao dirigir um carro, mas difacil para uma inteligaªncia artificial? Responder a essa pergunta éum grande desafio para os pesquisadores de IA. a‰ difacil para a IA porque conforme as cores de fundo mudam, sua entrada visual muda drasticamente, pois ele apenas "vaª" números no espaço do pixel. a‰ preciso muito treinamento para DQN aprender que duas situações que são dramaticamente diferentes no espaço do pixel são na verdade conceitualmente semelhantes em termos do que vocêdeve fazer. "

Por outro lado, acrescenta Cross, o cérebro humano émoldado ao longo de seu desenvolvimento para aprender a escolher as informações mais importantes para as tarefas dia¡rias comuns. “A via visual dorsal em particular, que énossa principal regia£o de interesse, écapaz de localizar objetos rapidamente, independentemente de suas coresâ€, diz ele. "Além disso, o cérebro de alguma forma codifica noções de bom senso de física e como os objetos normalmente se movem, o que permite aos humanos realizar uma ampla variedade de tarefas com pouco treinamento. Tudo isso tem que ser aprendido do zero por DQN."

Nos últimos anos, outras pesquisas descobriram semelhanças entre o cérebro e as redes neurais profundas, mas a maioria desses estudos se concentrou no reconhecimento de objetos, e não na tomada de decisão ativa. Este estudo apresenta uma nova estrutura para estudar o comportamento e a atividade cerebral em tarefas complexas de tomada de decisão que podem ser mais representativas da vida dia¡ria do que as tarefas anteriormente usadas no campo.

O artigo éintitulado "Usando o aprendizado por reforço profundo para revelar como o cérebro codifica representações de espaço de estado abstrato em ambientes de alta dimensão." Além de Cross e O'Doherty, co-autores adicionais são Jeff Cockburn, pesquisador pa³s-doutorado associado em neurociaªncia, e Yisong Yue , professor de computação e ciências matemáticas. O financiamento foi fornecido pelo Instituto Nacional de Abuso de Drogas e pelo Instituto Nacional de Saúde Mental e pelo Centro Caltech Conte para a Neurobiologia da Tomada de Decisão Social.