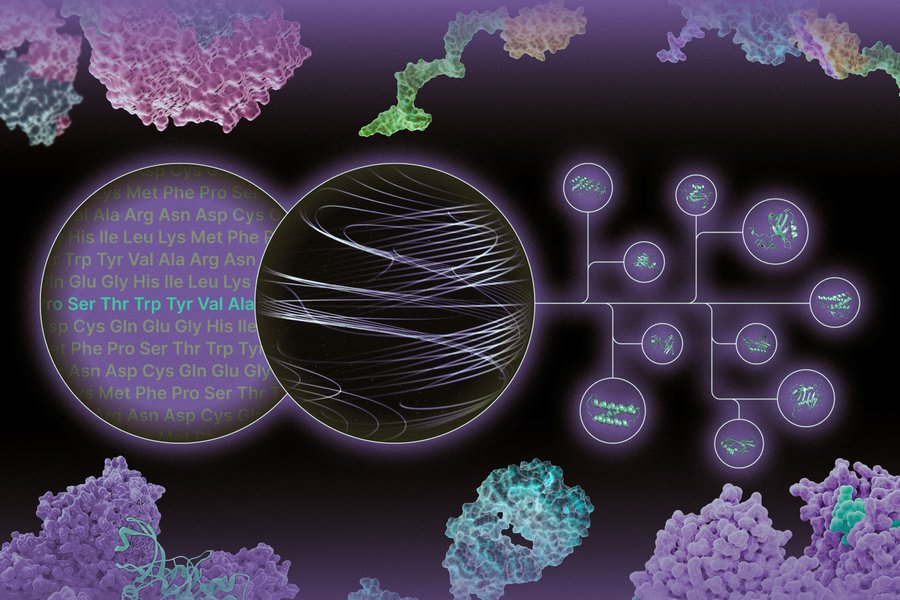

Talento

Raciocínio e confiabilidade em IA

Alunos de doutorado em estágio no Laboratório de IA do MIT-IBM Watson buscam melhorar o uso da linguagem natural.

No sentido horário, a partir do canto superior esquerdo: Athul Paul Jacob, Maohao Shen, Victor Butoi e Andi Peng. Créditos: Fotos cortesia dos pesquisadores.

Para que a linguagem natural seja uma forma eficaz de comunicação, as partes envolvidas precisam ser capazes de compreender as palavras e seu contexto, assumir que o conteúdo é amplamente compartilhado de boa fé e é confiável, raciocinar sobre as informações que estão sendo compartilhadas e então aplicá-lo a cenários do mundo real. Alunos de doutorado do MIT estagiando no MIT-IBM Watson AI Lab - Athul Paul Jacob SM '22, Maohao Shen SM '23, Victor Butoi e Andi Peng SM '23 - estão trabalhando para atacar cada etapa desse processo que é incorporado à linguagem natural modelos, para que os sistemas de IA possam ser mais confiáveis e precisos para os usuários.

Para conseguir isso, a pesquisa de Jacob atinge o cerne dos modelos de linguagem natural existentes para melhorar o resultado, usando a teoria dos jogos. Seus interesses, diz ele, são duplos: “Um é entender como os humanos se comportam, usando as lentes dos sistemas multiagentes e da compreensão da linguagem, e a segunda coisa é: 'Como você usa isso como um insight para construir uma IA melhor? sistemas?'” Seu trabalho deriva do jogo de tabuleiro “Diplomacia”, onde sua equipe de pesquisa desenvolveu um sistema que poderia aprender e prever comportamentos humanos e negociar estrategicamente para alcançar um resultado ideal e desejado.

“Este foi um jogo em que você precisa construir confiança; você precisa se comunicar usando a linguagem. Você também precisa jogar contra seis outros jogadores ao mesmo tempo, que eram muito diferentes de todos os tipos de domínios de tarefas que as pessoas enfrentavam no passado”, diz Jacob, referindo-se a outros jogos como pôquer e GO que os pesquisadores colocaram em redes neurais. . “Ao fazer isso, houve muitos desafios de pesquisa. Uma delas era: 'Como você modela os humanos? Como saber se os humanos tendem a agir irracionalmente?'” Jacob e seus mentores de pesquisa - incluindo o professor associado Jacob Andreas e a professora assistente Gabriele Farina do Departamento de Engenharia Elétrica e Ciência da Computação (EECS) do MIT e do MIT-IBM Watson Yikang Shen, do AI Lab – reformulou o problema da geração de linguagem como um jogo para dois jogadores.

Utilizando modelos de “gerador” e “discriminador”, a equipe de Jacob desenvolveu um sistema de linguagem natural para produzir respostas a perguntas e depois observar as respostas e determinar se estão corretas. Se estiverem, o sistema de IA recebe um ponto; caso contrário, nenhum ponto será recompensado. Os modelos de linguagem tendem notoriamente a alucinar, tornando-os menos confiáveis; esse algoritmo de aprendizagem sem arrependimento pega colaborativamente um modelo de linguagem natural e incentiva as respostas do sistema a serem mais verdadeiras e confiáveis, ao mesmo tempo que mantém as soluções próximas das anteriores do modelo de linguagem pré-treinado. Jacob diz que usar essa técnica em conjunto com um modelo de linguagem menor poderia, provavelmente, torná-la competitiva com o mesmo desempenho de um modelo muitas vezes maior.

Depois que um modelo de linguagem gera um resultado, o ideal é que os pesquisadores queiram que a confiança em sua geração se alinhe com sua precisão, mas isso frequentemente não é o caso. Podem ocorrer alucinações com o modelo relatando alta confiança quando deveria ser baixa. Maohao Shen e seu grupo, com os mentores Gregory Wornell, Professor Sumitomo de Engenharia no EECS, e pesquisadores de laboratório da IBM Research Subhro Das, Prasanna Sattigeri e Soumya Ghosh — estão procurando corrigir isso por meio da quantificação de incerteza (UQ). “Nosso projeto visa calibrar modelos de linguagem quando eles estão mal calibrados”, diz Shen. Especificamente, eles estão analisando o problema de classificação. Para isso, Shen permite que um modelo de linguagem gere texto livre, que é então convertido em uma tarefa de classificação de múltipla escolha. Por exemplo, eles podem pedir ao modelo para resolver um problema matemático e depois perguntar se a resposta gerada está correta como “sim, não ou talvez”. Isso ajuda a determinar se o modelo está excessivamente ou pouco confiante.

Automatizando isso, a equipe desenvolveu uma técnica que ajuda a ajustar a saída de confiança por meio de um modelo de linguagem pré-treinado. Os pesquisadores treinaram um modelo auxiliar usando informações verdadeiras para que seu sistema fosse capaz de corrigir o modelo de linguagem. “Se o seu modelo estiver excessivamente confiante na sua previsão, seremos capazes de detectá-lo e torná-lo menos confiante, e vice-versa”, explica Shen. A equipe avaliou sua técnica em vários conjuntos de dados de benchmark populares para mostrar quão bem ela generaliza para tarefas invisíveis para realinhar a precisão e a confiança das previsões do modelo de linguagem. “Após o treinamento, você pode simplesmente conectar e aplicar essa técnica a novas tarefas sem qualquer outra supervisão”, diz Shen. “A única coisa que você precisa são os dados para essa nova tarefa.”

Victor Butoi também aprimora a capacidade do modelo, mas, em vez disso, sua equipe de laboratório – que inclui John Guttag, professor Dugald C. Jackson de Ciência da Computação e Engenharia Elétrica no EECS; os pesquisadores de laboratório Leonid Karlinsky e Rogerio Feris da IBM Research; e os afiliados do laboratório Hilde Kühne da Universidade de Bonn e Wei Lin da Universidade de Tecnologia de Graz - estão criando técnicas para permitir que modelos de linguagem de visão raciocinem sobre o que estão vendo e estão projetando prompts para desbloquear novas habilidades de aprendizagem e compreender frases-chave .

O raciocínio composicional é apenas outro aspecto do processo de tomada de decisão que pedimos aos modelos de aprendizado de máquina para que sejam úteis em situações do mundo real, explica Butoi. “Você precisa ser capaz de pensar sobre a composição dos problemas e resolver subtarefas”, diz Butoi, “por exemplo, se você está dizendo que a cadeira está à esquerda da pessoa, você precisa reconhecer tanto a cadeira quanto a pessoa. Você precisa entender as instruções. E então, uma vez que o modelo entenda “esquerda”, a equipe de pesquisa deseja que o modelo seja capaz de responder a outras questões envolvendo “esquerda”.

Surpreendentemente, os modelos de linguagem de visão não raciocinam bem sobre a composição, explica Butoi, mas podem ser ajudados a fazê-lo, utilizando um modelo que possa “conduzir a testemunha”, se preferir. A equipe desenvolveu um modelo que foi ajustado usando uma técnica chamada adaptação de baixa classificação de modelos de linguagem grande (LoRA) e treinado em um conjunto de dados anotado chamado Visual Genome, que possui objetos em uma imagem e setas denotando relacionamentos, como direções. Nesse caso, o modelo LoRA treinado seria orientado a dizer algo sobre relacionamentos “esquerdos”, e essa saída de legenda seria então usada para fornecer contexto e estimular o modelo de linguagem de visão, tornando-o uma “tarefa significativamente mais fácil”, diz Butoi.

No mundo da robótica, os sistemas de IA também interagem com o ambiente usando visão computacional e linguagem. As configurações podem variar de armazéns até residências. Andi Peng e os mentores HN Slater Professor de Aeronáutica e Astronáutica do MIT Julie Shah e Chuang Gan, do laboratório e da Universidade de Massachusetts em Amherst, estão se concentrando em ajudar pessoas com restrições físicas, usando mundos virtuais. Para isso, o grupo de Peng está desenvolvendo dois modelos de IA incorporados — um “humano” que precisa de suporte e um agente auxiliar — em um ambiente simulado chamado ThreeDWorld. Concentrando-se nas interações humano/robô, a equipe aproveita os antecedentes semânticos capturados por grandes modelos de linguagem para ajudar a IA auxiliar a inferir quais habilidades o agente “humano” pode não ser capaz de executar e a motivação por trás das ações do “humano”, usando métodos naturais. linguagem. A equipe busca fortalecer a tomada de decisão sequencial do ajudante, a comunicação bidirecional, a capacidade de compreender a cena física e a melhor forma de contribuir.

“Muitas pessoas pensam que os programas de IA deveriam ser autônomos, mas acho que uma parte importante do processo é construirmos robôs e sistemas para humanos e queremos transmitir o conhecimento humano”, diz Peng. “Não queremos que um sistema faça algo de maneira estranha; queremos que eles façam isso de uma forma humana que possamos entender.”