Tecnologia Científica

Um sistema de aprendizado baseado em memristor crossbar para IA escalável e energeticamente eficiente

Os modelos de aprendizado profundo provaram ser ferramentas altamente valiosas para fazer previsões e resolver tarefas do mundo real que envolvem a análise de dados. Apesar de suas vantagens, antes de serem implantados em softwares...

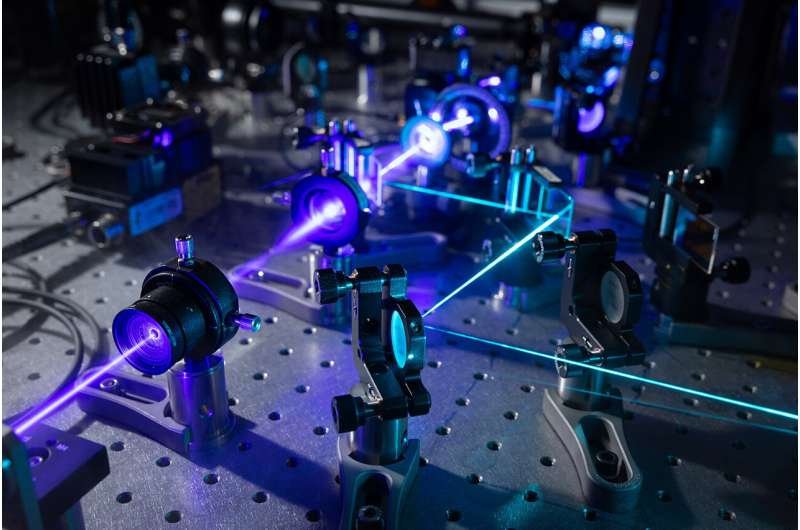

Um chip consistindo de crossbars de memristor foi treinado usando um algoritmo de aprendizado local no chip. A equipe demonstrou que sua abordagem poderia reconstruir com precisão as representações em Braille de nove famosos cientistas da computação a partir de entradas altamente distorcidas. Crédito: Yi et al.

Os modelos de aprendizado profundo provaram ser ferramentas altamente valiosas para fazer previsões e resolver tarefas do mundo real que envolvem a análise de dados. Apesar de suas vantagens, antes de serem implantados em softwares e dispositivos reais, como telefones celulares, esses modelos exigem treinamento extensivo em data centers físicos, o que pode consumir tempo e energia.

Pesquisadores da Texas A&M University, Rain Neuromorphics e Sandia National Laboratories desenvolveram recentemente um novo sistema para treinar modelos de aprendizado profundo de forma mais eficiente e em maior escala. Este sistema, apresentado em um artigo publicado na Nature Electronics , conta com o uso de novos algoritmos de treinamento e hardware memristor crossbar , que podem realizar várias operações ao mesmo tempo.

“A maioria das pessoas associa a IA ao monitoramento de saúde em relógios inteligentes, reconhecimento facial em smartphones etc. do estudo, disse.

"O treinamento acontece em data centers do tamanho de um depósito, o que é muito caro tanto economicamente quanto em termos de emissão de carbono. Apenas modelos totalmente treinados são então baixados para nossos dispositivos de baixo consumo."

Essencialmente, Kumar e seus colegas decidiram criar uma abordagem que pudesse reduzir a pegada de carbono e os custos financeiros associados ao treinamento de modelos de IA, tornando assim sua implementação em larga escala mais fácil e sustentável. Para fazer isso, eles tiveram que superar duas limitações principais das atuais práticas de treinamento de IA.

O primeiro desses desafios está associado ao uso de sistemas de hardware ineficientes baseados em unidades de processamento gráfico (GPUs), que não são inerentemente projetadas para executar e treinar modelos de aprendizado profundo. A segunda envolve o uso de ferramentas de software ineficazes e pesadas em matemática, especificamente utilizando o chamado algoritmo de retropropagação .

"Nosso objetivo era usar um novo hardware e novos algoritmos", explicou Kumar. "Aproveitamos nossos 15 anos anteriores de trabalho em hardware baseado em memristor (uma alternativa altamente paralela às GPUs) e avanços recentes em algoritmos eficientes semelhantes ao cérebro (uma técnica de aprendizado local sem retropropagação). Embora os avanços em hardware e software existissem anteriormente , nós os projetamos juntos para trabalharem juntos, o que permitiu um treinamento de IA muito eficiente em termos de energia."

O treinamento de redes neurais profundas envolve a adaptação contínua de sua configuração, composta pelos chamados "pesos", para garantir que ela possa identificar padrões em dados com precisão crescente. Esse processo de adaptação requer inúmeras multiplicações, que os processadores digitais convencionais lutam para executar com eficiência, pois precisarão buscar informações relacionadas ao peso de uma unidade de memória separada.

“Quase todo o treinamento hoje é realizado usando o algoritmo de retropropagação, que emprega movimentação significativa de dados e resolução de equações matemáticas e, portanto, é adequado para processadores digitais”, disse Suin Yi, principal autor do estudo.

"Como solução de hardware, crossbars de memristor analógicos, que surgiram na última década, permitem incorporar o peso sináptico no mesmo local onde ocorre a computação, minimizando assim a movimentação de dados. hardware, não são compatíveis com crossbars memristor devido ao seu ruído de hardware, erros e precisão limitada."

Como os algoritmos de retropropagação convencionais eram pouco adequados ao sistema que eles imaginaram, Kumar, Yi e seus colegas desenvolveram um novo algoritmo de aprendizado cootimizado que explora o paralelismo de hardware das barras transversais do memristor. Esse algoritmo, inspirado nas diferenças de atividade neuronal observadas em estudos de neurociência, é tolerante a erros e replica a capacidade do cérebro de aprender mesmo com informações esparsas, mal definidas e "ruidosas".

"Nosso sistema de hardware de algoritmo estuda as diferenças em como os neurônios sintéticos em uma rede neural se comportam de maneira diferente em duas condições diferentes: uma em que é permitido produzir qualquer saída de maneira livre e outra em que forçamos a saída a ser o alvo padrão que queremos identificar", explicou Yi.

"Ao estudar a diferença entre as respostas do sistema, podemos prever os pesos necessários para que o sistema chegue à resposta correta sem precisar forçá-lo. Ou seja, evitamos a retropropagação de equações matemáticas complexas, tornando o processo mais resiliente a ruídos, e permitindo o treinamento local, que é como o cérebro aprende novas tarefas."

O algoritmo compatível com hardware analógico e inspirado no cérebro desenvolvido como parte deste estudo poderia permitir a implementação de IA com eficiência energética em dispositivos de ponta com baterias pequenas, eliminando assim a necessidade de grandes servidores em nuvem que consomem grandes quantidades de energia elétrica. Isso poderia ajudar a tornar o treinamento em larga escala de algoritmos de aprendizado profundo mais acessível e sustentável.

“O algoritmo que usamos para treinar nossa rede neural combina alguns dos melhores aspectos do aprendizado profundo e da neurociência para criar um sistema que pode aprender de forma muito eficiente e com dispositivos de baixa precisão”, disse Jack Kendall, outro autor do artigo.

"Isso tem muitas implicações. A primeira é que, usando nossa abordagem, os modelos de IA que atualmente são muito grandes para serem implantados podem caber em celulares, smartwatches e outros dispositivos sem fio. Outra é que essas redes agora podem aprender on- instantaneamente, enquanto são implantados, por exemplo, para dar conta de ambientes em mudança ou para manter os dados do usuário locais (evitando enviá-los para a nuvem para treinamento)."

Em avaliações iniciais, Kumar, Yi, Kendall e seu colega Stanley Williams mostraram que sua abordagem pode reduzir o consumo de energia associado ao treinamento de IA em até 100.000 vezes quando comparado até mesmo às melhores GPUs do mercado atualmente. No futuro, poderia permitir a transferência de data centers massivos para os dispositivos pessoais dos usuários, reduzindo a pegada de carbono associada ao treinamento de IA e promovendo o desenvolvimento de mais redes neurais artificiais que suportam ou simplificam as atividades humanas diárias.

"Planejamos estudar como esses sistemas se adaptam a redes muito maiores e tarefas mais difíceis", acrescentou Kendall. "Também planejamos estudar uma variedade de algoritmos de aprendizado inspirados no cérebro para treinar redes neurais profundas e descobrir quais deles têm melhor desempenho em diferentes redes e com diferentes restrições de recursos de hardware. Acreditamos que isso não apenas nos ajudará a entender como melhor desempenho de aprendizagem em ambientes com recursos limitados, mas também pode nos ajudar a entender como os cérebros biológicos são capazes de aprender com uma eficiência tão incrível."

Mais informações: Su-in Yi et al, Activity-difference training of deep neural networks using memristor crossbars, Nature Electronics (2022). DOI: 10.1038/s41928-022-00869-w

Informações do jornal: Nature Electronics

.jpg)