Tecnologia Científica

Ajudar modelos de visão computacional e linguagem a entender o que veem

Os pesquisadores usam dados sintéticos para melhorar a capacidade de um modelo de captar informações conceituais, o que poderia aprimorar os sistemas automáticos de legendas e respostas a perguntas.

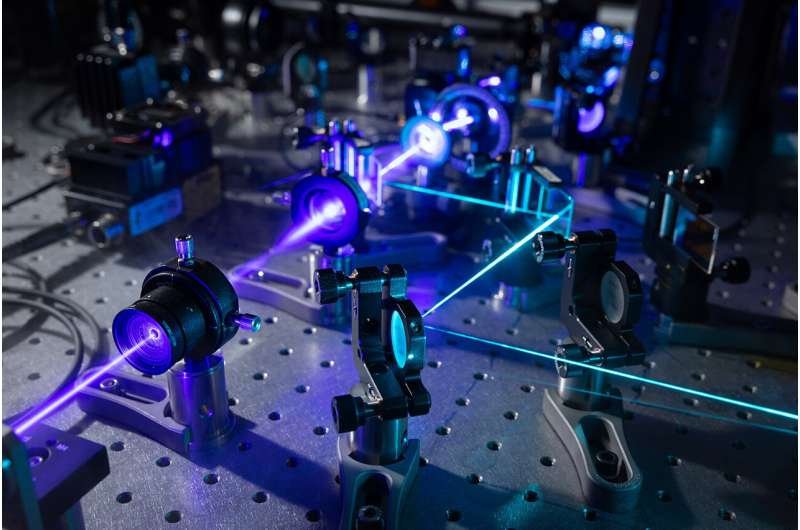

Os pesquisadores do MIT criaram um novo conjunto de dados sintéticos anotados de imagens que retratam uma ampla variedade de cenários, que podem ser usados ??para ajudar os modelos de aprendizado de máquina a compreender os conceitos de uma cena.

Créditos: Cortesia dos pesquisadores

Poderosos algoritmos de aprendizado de máquina conhecidos como modelos de visão e linguagem, que aprendem a combinar texto com imagens, mostraram resultados notáveis ??quando solicitados a gerar legendas ou resumir vídeos.

Embora esses modelos sejam excelentes na identificação de objetos, eles muitas vezes têm dificuldade para compreender conceitos, como atributos de objetos ou a disposição de itens em uma cena. Por exemplo, um modelo de visão e linguagem pode reconhecer a xícara e a mesa em uma imagem, mas não consegue compreender que a xícara está sobre a mesa.

Pesquisadores do MIT, do MIT-IBM Watson AI Lab e de outros lugares demonstraram uma nova técnica que utiliza dados gerados por computador para ajudar os modelos de visão e linguagem a superar essa deficiência.

Os pesquisadores criaram um conjunto de dados sintéticos de imagens que retratam uma ampla variedade de cenários, arranjos de objetos e ações humanas, juntamente com descrições detalhadas de texto. Eles usaram esse conjunto de dados anotados para “consertar” modelos de visão e linguagem para que pudessem aprender conceitos de forma mais eficaz. Sua técnica garante que esses modelos ainda possam fazer previsões precisas quando virem imagens reais.

Quando testaram modelos de compreensão de conceitos, os pesquisadores descobriram que sua técnica aumentou a precisão em até 10%. Isto poderia melhorar os sistemas que legendam vídeos automaticamente ou aprimorar modelos que fornecem respostas em linguagem natural a perguntas sobre imagens, com aplicações em áreas como comércio eletrônico ou saúde.

“Com este trabalho, estamos indo além dos substantivos, no sentido de que estamos indo além dos nomes dos objetos, para mais do conceito semântico de um objeto e de tudo ao seu redor. Nossa ideia era que, quando um modelo de aprendizado de máquina vê objetos em muitos arranjos diferentes, ele terá uma ideia melhor de como o arranjo é importante em uma cena”, diz Khaled Shehada, estudante de pós-graduação do Departamento de Engenharia Elétrica e Ciência da Computação e co-autor de um artigo sobre esta técnica.

Shehada escreveu o artigo com a autora principal Paola Cascante-Bonilla, estudante de graduação em ciência da computação na Rice University; Aude Oliva, diretora de engajamento estratégico da indústria no MIT Schwarzman College of Computing, diretora do MIT-IBM Watson AI Lab do MIT e pesquisadora sênior do Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL); autor sênior Leonid Karlinsky, membro da equipe de pesquisa do MIT-IBM Watson AI Lab; e outros no MIT, no MIT-IBM Watson AI Lab, na Georgia Tech, na Rice University, na École des Ponts, no Weizmann Institute of Science e na IBM Research. O artigo será apresentado na Conferência Internacional sobre Visão Computacional.

Focando em objetos

Os modelos de visão e linguagem normalmente aprendem a identificar objetos em uma cena e podem acabar ignorando atributos do objeto, como cor e tamanho, ou relações posicionais, como qual objeto está em cima de outro objeto.

Isto se deve ao método com o qual esses modelos são frequentemente treinados, conhecido como aprendizagem contrastiva. Este método de treinamento envolve forçar um modelo a prever a correspondência entre imagens e texto. Ao comparar imagens naturais, os objetos em cada cena tendem a causar as diferenças mais marcantes. (Talvez uma imagem mostre um cavalo num campo, enquanto a segunda mostra um veleiro na água.)

“Cada imagem pode ser definida exclusivamente pelos objetos na imagem. Então, quando você faz aprendizagem contrastiva, focar apenas nos substantivos e objetos resolveria o problema. Por que o modelo faria algo diferente?” diz Karlinsky.

Os pesquisadores procuraram mitigar esse problema usando dados sintéticos para ajustar uma visão e um modelo de linguagem. O processo de ajuste fino envolve ajustar um modelo que já foi treinado para melhorar seu desempenho em uma tarefa específica.

Eles usaram um computador para criar automaticamente vídeos sintéticos com diversos ambientes e objetos 3D, como móveis e malas, e adicionaram avatares humanos que interagiam com os objetos.

Usando frames individuais desses vídeos, eles geraram quase 800 mil imagens fotorrealistas e, em seguida, combinaram cada uma com uma legenda detalhada. Os pesquisadores desenvolveram uma metodologia para anotar cada aspecto da imagem para capturar atributos de objetos, relações posicionais e interações homem-objeto de forma clara e consistente em legendas densas.

Como os pesquisadores criaram as imagens, eles puderam controlar a aparência e a posição dos objetos, bem como o gênero, as roupas, as poses e as ações dos avatares humanos.

“Os dados sintéticos permitem muita diversidade. Com imagens reais, você pode não ter muitos elefantes em uma sala, mas com dados sintéticos, você poderia realmente ter um elefante rosa em uma sala com um humano, se quiser”, diz Cascante-Bonilla.

Os dados sintéticos também têm outras vantagens. Eles são mais baratos de gerar do que dados reais, mas as imagens são altamente fotorrealistas. Eles também preservam a privacidade porque nenhum ser humano real é mostrado nas imagens. E, como os dados são produzidos automaticamente por um computador, podem ser gerados rapidamente em grandes quantidades.

Ao utilizar diferentes pontos de vista da câmara ou alterar ligeiramente as posições ou atributos dos objetos, os investigadores criaram um conjunto de dados com uma variedade muito maior de cenários do que se encontraria num conjunto de dados natural.

Afine, mas não se esqueça

No entanto, quando se ajusta um modelo com dados sintéticos, existe o risco de o modelo “esquecer” o que aprendeu quando foi originalmente treinado com dados reais.

Os pesquisadores empregaram algumas técnicas para evitar esse problema, como ajustar os dados sintéticos para que as cores, a iluminação e as sombras correspondam mais às encontradas nas imagens naturais. Eles também fizeram ajustes no funcionamento interno do modelo após o ajuste fino para reduzir ainda mais qualquer esquecimento.

Seu conjunto de dados sintéticos e estratégia de ajuste fino melhoraram a capacidade dos modelos populares de visão e linguagem de reconhecer conceitos com precisão em até 10%. Ao mesmo tempo, as modelos não esqueceram o que já aprenderam.

Agora que mostraram como os dados sintéticos podem ser usados ??para resolver este problema, os investigadores querem identificar formas de melhorar a qualidade visual e a diversidade destes dados, bem como a física subjacente que faz com que as cenas sintéticas pareçam realistas. Além disso, eles planejam testar os limites da escalabilidade e investigar se a melhoria do modelo começa a estagnar com conjuntos de dados sintéticos maiores e mais diversos.

Esta pesquisa é financiada, em parte, pela Agência de Projetos de Pesquisa Avançada de Defesa dos EUA, pela National Science Foundation e pelo MIT-IBM Watson AI Lab.

.jpg)