Tecnologia Científica

Algoritmo de treinamento quebra barreiras para redes neurais físicas profundas

Os pesquisadores da EPFL desenvolveram um algoritmo para treinar uma rede neural analógica com a mesma precisão que uma digital, permitindo o desenvolvimento de alternativas mais eficientes para hardware de aprendizado profundo...

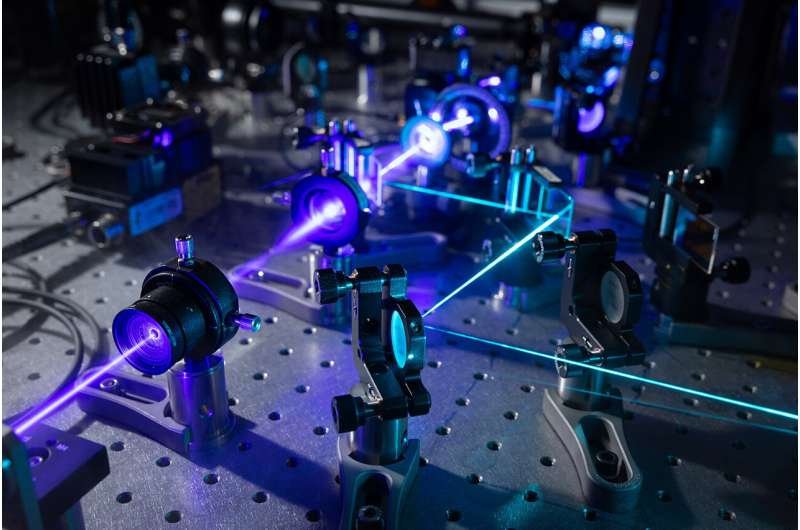

Imagem conceitual gerada por IA (DALL-E 3) representando ondas de luz passando por um sistema físico. Crédito: LWE/EPFL

Os pesquisadores da EPFL desenvolveram um algoritmo para treinar uma rede neural analógica com a mesma precisão que uma digital, permitindo o desenvolvimento de alternativas mais eficientes para hardware de aprendizado profundo que consome muita energia.

Com sua capacidade de processar grandes quantidades de dados por meio de “aprendizado” algorítmico em vez de programação tradicional, muitas vezes parece que o potencial de redes neurais profundas como o Chat-GPT é ilimitado. Mas à medida que o âmbito e o impacto destes sistemas aumentaram, também aumentaram a sua dimensão, complexidade e consumo de energia — sendo este último suficientemente significativo para levantar preocupações sobre as contribuições para as emissões globais de carbono.

Embora muitas vezes pensemos no avanço tecnológico em termos de mudança do analógico para o digital, os investigadores procuram agora respostas para este problema em alternativas físicas às redes neurais profundas digitais. Um desses pesquisadores é Romain Fleury, do Laboratório de Engenharia de Ondas da Escola de Engenharia da EPFL.

Em um artigo publicado na Science , ele e seus colegas descrevem um algoritmo para treinar sistemas físicos que mostra maior velocidade, maior robustez e menor consumo de energia em comparação com outros métodos.

"Testamos com sucesso nosso algoritmo de treinamento em três sistemas físicos baseados em ondas que usam ondas sonoras , ondas de luz e micro-ondas para transportar informações, em vez de elétrons. Mas nossa abordagem versátil pode ser usada para treinar qualquer sistema físico", diz o primeiro autor e Pesquisador da LWE, Ali Momeni.

Uma abordagem “mais biologicamente plausível”

O treinamento em redes neurais refere-se a ajudar os sistemas a aprenderem a gerar valores ideais de parâmetros para uma tarefa como reconhecimento de imagem ou fala. Tradicionalmente, envolve duas etapas: uma passagem para frente, onde os dados são enviados através da rede e uma função de erro é calculada com base na saída, e uma passagem para trás (também conhecida como retropropagação, ou BP), onde um gradiente da função de erro com respeito a todos os parâmetros da rede é calculado.

Ao longo de repetidas iterações, o sistema se atualiza com base nesses dois cálculos para retornar valores cada vez mais precisos. O problema? Além de consumir muita energia, o BP é pouco adequado para sistemas físicos. Na verdade, os sistemas físicos de treinamento geralmente exigem um gêmeo digital para a etapa de BP, o que é ineficiente e acarreta o risco de uma incompatibilidade de simulação da realidade.

Os cientistas propuseram substituir a etapa BP por uma segunda passagem direta através do sistema físico para atualizar cada camada de rede localmente. Além de diminuir o consumo de energia e eliminar a necessidade de um gêmeo digital, esse método reflete melhor o aprendizado humano.

“A estrutura das redes neurais é inspirada no cérebro, mas é improvável que o cérebro aprenda através do BP”, explica Momeni. "A ideia aqui é que, se treinarmos cada camada física localmente, poderemos usar nosso sistema físico real em vez de primeiro construir um modelo digital dele. Portanto, desenvolvemos uma abordagem que é biologicamente mais plausível."

Os pesquisadores da EPFL, com Philipp del Hougne do CNRS IETR e Babak Rahmani da Microsoft Research, usaram seu algoritmo físico de aprendizagem local (PhyLL) para treinar sistemas experimentais acústicos e de micro-ondas e um sistema óptico modelado para classificar dados como sons vocálicos e imagens. Além de mostrar precisão comparável ao treinamento baseado em BP, o método foi robusto e adaptável – mesmo em sistemas expostos a perturbações externas imprevisíveis – em comparação com o estado da arte.

Um futuro analógico?

Embora a abordagem do LWE seja o primeiro treinamento livre de BP de redes neurais físicas profundas, algumas atualizações digitais dos parâmetros ainda são necessárias. “É uma abordagem de treinamento híbrida, mas nosso objetivo é diminuir ao máximo a computação digital”, diz Momeni.

Os pesquisadores esperam agora implementar seu algoritmo em um sistema óptico de pequena escala com o objetivo final de aumentar a escalabilidade da rede.

“Em nossos experimentos, usamos redes neurais com até 10 camadas, mas será que ainda funcionaria com 100 camadas com bilhões de parâmetros? Este é o próximo passo e exigirá a superação das limitações técnicas dos sistemas físicos.”

Mais informações: Ali Momeni et al, Treinamento livre de retropropagação de redes neurais físicas profundas, Science (2023). DOI: 10.1126/science.adi8474

Informações da revista: Ciência

.jpg)