Tecnologia Científica

Redes neurais profundas se mostram promissoras como modelos de audição humana

Estudo mostra que modelos computacionais treinados para a realização de tarefas auditivas apresentam uma organização interna semelhante à do córtex auditivo humano.

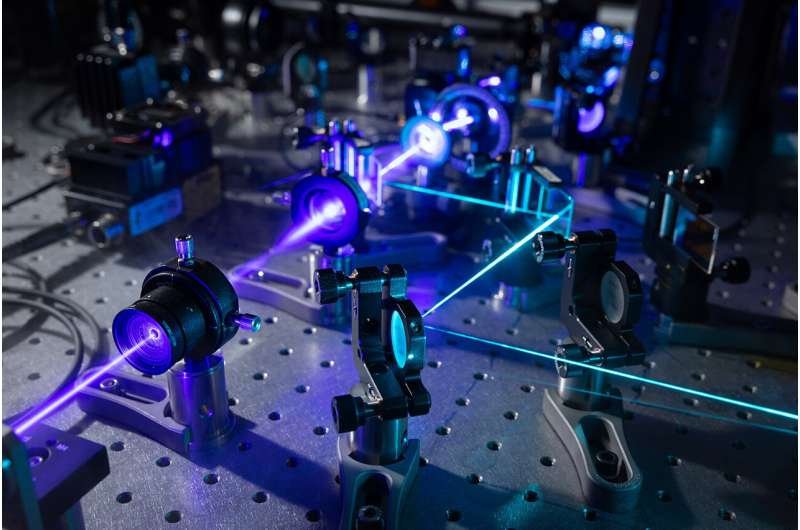

No maior estudo já feito sobre redes neurais profundas treinadas para realizar tarefas auditivas, os pesquisadores do MIT descobriram que a maioria desses modelos gera representações internas que compartilham propriedades de representações vistas no cérebro humano quando as pessoas estão ouvindo os mesmos sons. Imagem: iStock

Modelos computacionais que mimetizam a estrutura e a função do sistema auditivo humano podem ajudar os pesquisadores a projetar melhores aparelhos auditivos, implantes cocleares e interfaces cérebro-máquina. Um novo estudo do MIT descobriu que modelos computacionais modernos derivados do aprendizado de máquina estão se aproximando desse objetivo.

No maior estudo até agora de redes neurais profundas que foram treinadas para realizar tarefas auditivas, a equipe do MIT mostrou que a maioria desses modelos gera representações internas que compartilham propriedades de representações vistas no cérebro humano quando as pessoas estão ouvindo os mesmos sons.

O estudo também oferece informações sobre a melhor forma de treinar esse tipo de modelo: os pesquisadores descobriram que modelos treinados em entrada auditiva, incluindo ruído de fundo, imitam mais de perto os padrões de ativação do córtex auditivo humano.

"O que diferencia este estudo é que é a comparação mais abrangente desses tipos de modelos com o sistema auditivo até agora. O estudo sugere que os modelos derivados do aprendizado de máquina são um passo na direção certa, e nos dá algumas pistas sobre o que tende a torná-los melhores modelos do cérebro", diz Josh McDermott, professor associado de ciências cerebrais e cognitivas do MIT, membro do Instituto McGovern de Pesquisa do Cérebro e do Centro de Cérebros do MIT. Mentes e Máquinas, e o autor sênior do estudo.

A estudante de pós-graduação do MIT Greta Tuckute e Jenelle Feather PhD '22 são as principais autoras do artigo de acesso aberto, que aparece hoje na PLOS Biology.

Modelos de audição

Redes neurais profundas são modelos computacionais que consistem em muitas camadas de unidades de processamento de informações que podem ser treinadas em grandes volumes de dados para executar tarefas específicas. Esse tipo de modelo se tornou amplamente utilizado em muitas aplicações, e os neurocientistas começaram a explorar a possibilidade de que esses sistemas também possam ser usados para descrever como o cérebro humano executa certas tarefas.

"Esses modelos que são construídos com aprendizado de máquina são capazes de mediar comportamentos em uma escala que realmente não era possível com tipos anteriores de modelos, e isso levou ao interesse em saber se as representações nos modelos poderiam ou não capturar coisas que estão acontecendo no cérebro", diz Tuckute.

Quando uma rede neural está executando uma tarefa, suas unidades de processamento geram padrões de ativação em resposta a cada entrada de áudio que recebe, como uma palavra ou outro tipo de som. Essas representações de modelo da entrada podem ser comparadas aos padrões de ativação vistos em varreduras cerebrais de fMRI de pessoas ouvindo a mesma entrada.

Em 2018, McDermott e o então estudante de pós-graduação Alexander Kell relataram que, quando treinaram uma rede neural para realizar tarefas auditivas (como reconhecer palavras de um sinal de áudio), as representações internas geradas pelo modelo mostraram semelhança com as observadas em exames de RMf de pessoas ouvindo os mesmos sons.

Desde então, esses tipos de modelos se tornaram amplamente utilizados, então o grupo de pesquisa de McDermott se propôs a avaliar um conjunto maior de modelos, para ver se a capacidade de aproximar as representações neurais vistas no cérebro humano é uma característica geral desses modelos.

Para este estudo, os pesquisadores analisaram nove modelos de redes neurais profundas disponíveis publicamente que foram treinados para realizar tarefas auditivas e também criaram 14 modelos próprios, baseados em duas arquiteturas diferentes. A maioria desses modelos foi treinada para realizar uma única tarefa – reconhecer palavras, identificar o falante, reconhecer sons ambientais e identificar gênero musical – enquanto dois deles foram treinados para realizar múltiplas tarefas.

Quando os pesquisadores apresentaram esses modelos com sons naturais que haviam sido usados como estímulos em experimentos de fMRI humanos, eles descobriram que as representações internas do modelo tendiam a exibir semelhança com aquelas geradas pelo cérebro humano. Os modelos cujas representações eram mais semelhantes àquelas observadas no cérebro eram modelos que haviam sido treinados em mais de uma tarefa e haviam sido treinados em input auditivo que incluía ruído de fundo.

"Se você treinar modelos em ruído, eles dão melhores previsões cerebrais do que se você não treinar, o que é intuitivamente razoável porque muita audição do mundo real envolve ouvir em ruído, e isso é plausivelmente algo ao qual o sistema auditivo está adaptado", diz Feather.

Processamento hierárquico

O novo estudo também apoia a ideia de que o córtex auditivo humano tem algum grau de organização hierárquica, em que o processamento é dividido em estágios que suportam funções computacionais distintas. Como no estudo de 2018, os pesquisadores descobriram que as representações geradas em estágios anteriores do modelo se assemelham mais àquelas vistas no córtex auditivo primário, enquanto as representações geradas em estágios posteriores do modelo se assemelham mais àquelas geradas em regiões cerebrais além do córtex primário.

Além disso, os pesquisadores descobriram que modelos que haviam sido treinados em diferentes tarefas eram melhores em replicar diferentes aspectos da audição. Por exemplo, modelos treinados em uma tarefa relacionada à fala mais se assemelhavam a áreas seletivas de fala.

"Mesmo que o modelo tenha visto exatamente os mesmos dados de treinamento e a arquitetura seja a mesma, quando você otimiza para uma tarefa específica, você pode ver que ele explica seletivamente propriedades específicas de ajuste no cérebro", diz Tukute.

O laboratório de McDermott agora planeja usar suas descobertas para tentar desenvolver modelos que sejam ainda mais bem-sucedidos na reprodução de respostas cerebrais humanas. Além de ajudar os cientistas a aprender mais sobre como o cérebro pode ser organizado, esses modelos também podem ser usados para ajudar a desenvolver melhores aparelhos auditivos, implantes cocleares e interfaces cérebro-máquina.

"Um objetivo do nosso campo é chegar a um modelo computacional que possa prever as respostas e o comportamento do cérebro. Acreditamos que, se formos bem-sucedidos em alcançar esse objetivo, isso abrirá muitas portas", diz McDermott.

A pesquisa foi financiada pelos Institutos Nacionais de Saúde, uma bolsa Amazon do Science Hub, uma bolsa de doutorado internacional da Associação Americana de Mulheres Universitárias, uma bolsa MIT Friends of McGovern Institute, uma bolsa do K. Lisa Yang Integrative Computational Neuroscience (ICoN) Center no MIT e uma bolsa de pós-graduação do Departamento de Ciência Computacional de Energia.

.jpg)