Tecnologia Científica

Como a simetria pode ajudar o aprendizado de máquina

Explorar a simetria dentro dos conjuntos de dados, mostram os pesquisadores do MIT, pode diminuir a quantidade de dados necessários para treinar redes neurais.

Uma nova pesquisa do MIT fornece uma prova teórica para um fenômeno observado na prática: que a codificação de simetrias no modelo de aprendizado de máquina ajuda o modelo a aprender com menos dados. Créditos: Imagem: Alex Shipps/MIT CSAIL

Behrooz Tahmasebi – um estudante de doutorado do MIT no Departamento de Engenharia Elétrica e Ciência da Computação (EECS) e afiliado do Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL) – estava fazendo um curso de matemática sobre equações diferenciais no final de 2021, quando um raio de inspiração chocado. Nessa aula, ele aprendeu pela primeira vez sobre a lei de Weyl, formulada 110 anos antes pelo matemático alemão Hermann Weyl. Tahmasebi percebeu que isso poderia ter alguma relevância para o problema de ciência da computação com o qual ele estava lutando, embora a conexão parecesse – superficialmente – ser tênue, na melhor das hipóteses. A lei de Weyl, diz ele, fornece uma fórmula que mede a complexidade da informação espectral, ou dados, contidos nas frequências fundamentais de uma pele de tambor ou corda de guitarra.

Tahmasebi estava, ao mesmo tempo, pensando em medir a complexidade dos dados de entrada para uma rede neural, perguntando-se se essa complexidade poderia ser reduzida levando em consideração algumas das simetrias inerentes ao conjunto de dados. Tal redução, por sua vez, poderia facilitar — e também acelerar — os processos de aprendizado de máquina.

A lei de Weyl, concebida cerca de um século antes do boom do aprendizado de máquina, tinha sido tradicionalmente aplicada a situações físicas muito diferentes - como aquelas relacionadas às vibrações de uma corda ou ao espectro de radiação eletromagnética (corpo negro) emitida por um objeto aquecido. No entanto, Tahmasebi acreditava que uma versão personalizada dessa lei poderia ajudar no problema de aprendizado de máquina que ele estava perseguindo. E se a abordagem desse certo, a recompensa poderia ser considerável.

Ele conversou com sua orientadora, Stefanie Jegelka – professora associada do EECS e afiliada do CSAIL e do Instituto de Dados, Sistemas e Sociedade do MIT – que acreditava que definitivamente valia a pena analisar a ideia. Na opinião de Tahmasebi, a lei de Weyl tinha a ver com a medição da complexidade dos dados, e o mesmo aconteceu com este projeto. Mas a lei de Weyl, na sua forma original, nada dizia sobre simetria.

Ele e Jegelka conseguiram agora modificar a lei de Weyl para que a simetria possa ser levada em consideração na avaliação da complexidade de um conjunto de dados. “Até onde sei”, diz Tahmasebi, “esta é a primeira vez que a lei de Weyl foi usada para determinar como o aprendizado de máquina pode ser aprimorado pela simetria”.

O artigo que ele e Jegelka escreveram ganhou a designação de “Destaque” quando foi apresentado na conferência de dezembro de 2023 sobre Sistemas de Processamento de Informação Neural – amplamente considerada a principal conferência do mundo sobre aprendizado de máquina.

Este trabalho, comenta Soledad Villar, matemática aplicada da Universidade Johns Hopkins, “mostra que os modelos que satisfazem as simetrias do problema não só são corretos, mas também podem produzir previsões com erros menores, usando uma pequena quantidade de pontos de treinamento. [Isso] é especialmente importante em domínios científicos, como a química computacional, onde os dados de treinamento podem ser escassos.”

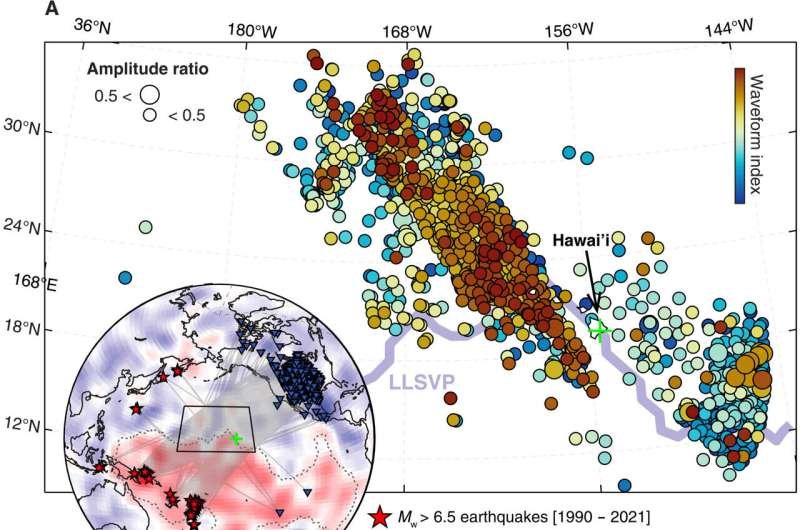

Em seu artigo, Tahmasebi e Jegelka exploraram as maneiras pelas quais as simetrias, ou as chamadas “invariâncias”, poderiam beneficiar o aprendizado de máquina. Suponha, por exemplo, que o objetivo de uma determinada execução de computador seja selecionar todas as imagens que contenham o numeral 3. Essa tarefa pode ser muito mais fácil e muito mais rápida se o algoritmo puder identificar o 3, independentemente de onde esteja. colocado na caixa - esteja exatamente no centro ou lateralmente - e esteja apontado para o lado direito, de cabeça para baixo ou orientado em um ângulo aleatório. Um algoritmo equipado com esta última capacidade pode tirar vantagem das simetrias de translação e rotações, o que significa que um 3, ou qualquer outro objeto, não é alterado em si mesmo alterando sua posição ou girando-o em torno de um eixo arbitrário. Diz-se que é invariante a essas mudanças. A mesma lógica pode ser aplicada a algoritmos encarregados de identificar cães ou gatos. Um cachorro é um cachorro, pode-se dizer, independentemente de como esteja incorporado em uma imagem.

O objetivo de todo o exercício, explicam os autores, é explorar as simetrias intrínsecas de um conjunto de dados para reduzir a complexidade das tarefas de aprendizado de máquina. Isso, por sua vez, pode levar a uma redução na quantidade de dados necessários para a aprendizagem. Concretamente, o novo trabalho responde à pergunta: quantos dados a menos são necessários para treinar um modelo de aprendizado de máquina se os dados contêm simetrias?

Existem duas formas de obter um ganho, ou benefício, capitalizando as simetrias presentes. A primeira tem a ver com o tamanho da amostra a ser analisada. Vamos imaginar que você esteja encarregado, por exemplo, de analisar uma imagem que tenha simetria espelhada – sendo o lado direito uma réplica exata, ou imagem espelhada, do esquerdo. Nesse caso, você não precisa olhar cada pixel; você pode obter todas as informações necessárias de metade da imagem - uma melhoria de fator de dois. Se, por outro lado, a imagem puder ser particionada em 10 partes idênticas, você poderá obter um fator de melhoria de 10. Este tipo de efeito de reforço é linear.

Para dar outro exemplo, imagine que você está vasculhando um conjunto de dados, tentando encontrar sequências de blocos que tenham sete cores diferentes – preto, azul, verde, roxo, vermelho, branco e amarelo. Seu trabalho fica muito mais fácil se você não se importa com a ordem em que os blocos estão dispostos. Se a ordem importasse, haveria 5.040 combinações diferentes para procurar. Mas se tudo o que importa são sequências de blocos em que todas as sete cores aparecem, então você reduziu o número de coisas – ou sequências – que está procurando de 5.040 para apenas uma.

Tahmasebi e Jegelka descobriram que é possível obter um tipo diferente de ganho – exponencial – que pode ser obtido para simetrias que operam em muitas dimensões. Esta vantagem está relacionada com a noção de que a complexidade de uma tarefa de aprendizagem cresce exponencialmente com a dimensionalidade do espaço de dados. Fazer uso de uma simetria multidimensional pode, portanto, produzir um retorno desproporcionalmente grande. “Esta é uma nova contribuição que basicamente nos diz que as simetrias de dimensões superiores são mais importantes porque podem nos dar um ganho exponencial”, diz Tahmasebi.

O artigo NeurIPS 2023 que ele escreveu com Jegelka contém dois teoremas que foram provados matematicamente. “O primeiro teorema mostra que uma melhoria na complexidade da amostra é alcançável com o algoritmo geral que fornecemos”, diz Tahmasebi. O segundo teorema complementa o primeiro, acrescentou, “mostrando que este é o melhor ganho possível que se pode obter; nada mais é alcançável.”

Ele e Jegelka forneceram uma fórmula que prevê o ganho que pode ser obtido com uma simetria específica em uma determinada aplicação. Uma virtude desta fórmula é a sua generalidade, observa Tahmasebi. “Funciona para qualquer simetria e qualquer espaço de entrada.” Funciona não apenas para simetrias conhecidas hoje, mas também poderá ser aplicado no futuro a simetrias que ainda não foram descobertas. Esta última perspectiva não é demasiado rebuscada para ser considerada, dado que a procura de novas simetrias tem sido há muito um grande impulso na física. Isto sugere que, à medida que mais simetrias forem encontradas, a metodologia introduzida por Tahmasebi e Jegelka só deverá melhorar com o tempo.

De acordo com Haggai Maron, cientista da computação do Technion (Instituto de Tecnologia de Israel) e da NVIDIA que não esteve envolvido no trabalho, a abordagem apresentada no artigo “diverge substancialmente de trabalhos anteriores relacionados, adotando uma perspectiva geométrica e empregando ferramentas de diferencial geometria. Esta contribuição teórica dá suporte matemático ao subcampo emergente de 'Aprendizagem Geométrica Profunda', que tem aplicações em aprendizagem de gráficos, dados 3D e muito mais. O artigo ajuda a estabelecer uma base teórica para orientar futuros desenvolvimentos nesta área de pesquisa em rápida expansão.”