Tecnologia Científica

Os LLMs podem ajudar a projetar nossos próximos medicamentos e materiais?

Um novo método permite que os usuários solicitem, em linguagem simples, uma nova molécula com certas propriedades e recebam uma descrição detalhada de como sintetizá-la.

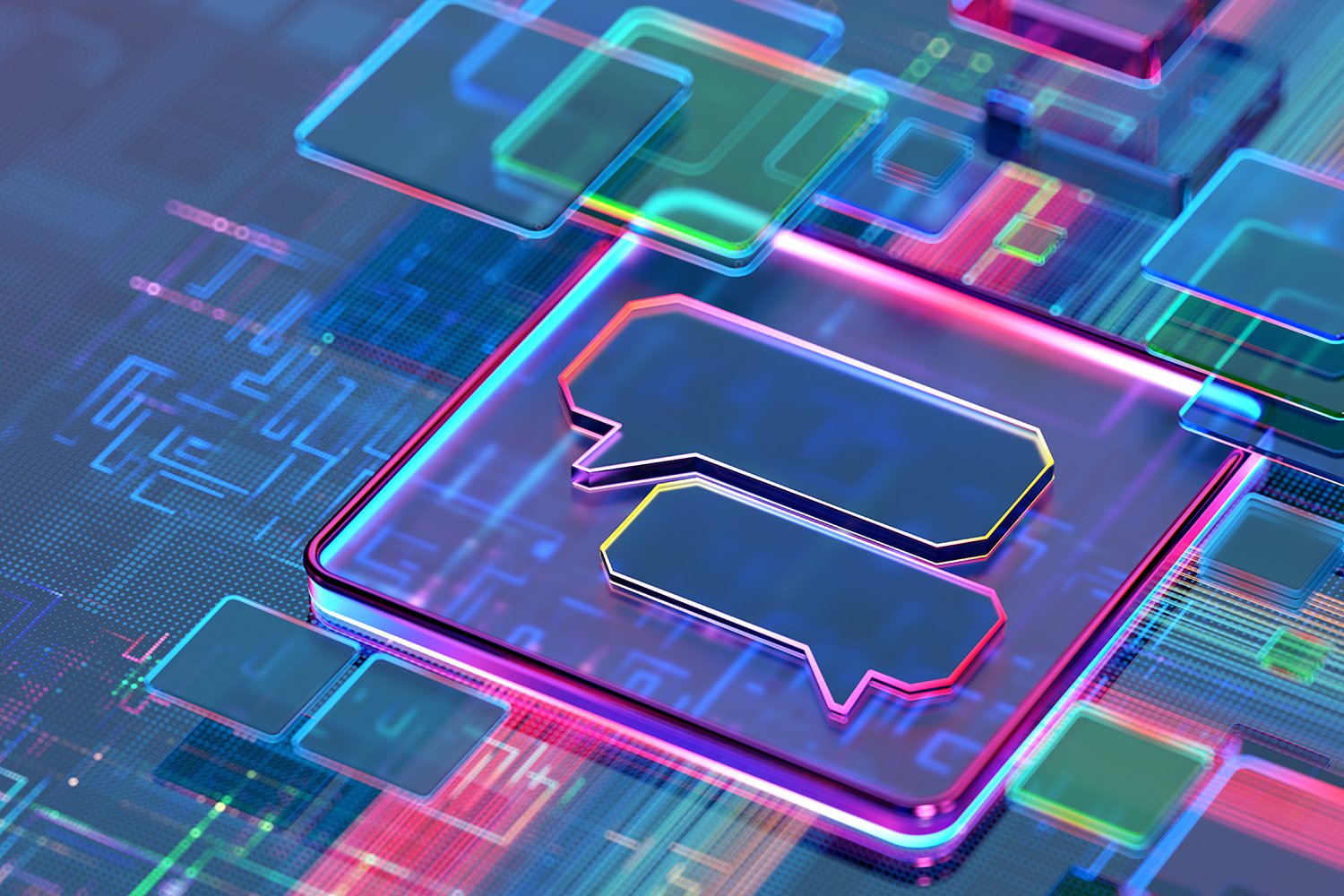

Pesquisadores desenvolveram uma ferramenta multimodal que combina um grande modelo de linguagem com poderosos modelos de IA baseados em gráficos para encontrar com eficiência novas moléculas sintetizáveis com propriedades desejadas com base nas consultas do usuário em linguagem simples. Créditos: Imagem: MIT News; iStock

O processo de descoberta de moléculas que tenham as propriedades necessárias para criar novos medicamentos e materiais é trabalhoso e caro, consumindo vastos recursos computacionais e meses de trabalho humano para reduzir o enorme espaço de potenciais candidatos.

Grandes modelos de linguagem (LLMs) como o ChatGPT poderiam agilizar esse processo, mas permitir que um LLM entenda e raciocine sobre os átomos e ligações que formam uma molécula, da mesma forma que faz com as palavras que formam frases, apresentou um obstáculo científico.

Pesquisadores do MIT e do MIT-IBM Watson AI Lab criaram uma abordagem promissora que complementa um LLM com outros modelos de aprendizado de máquina conhecidos como modelos baseados em gráficos, que são projetados especificamente para gerar e prever estruturas moleculares.

O método utiliza um LLM básico para interpretar consultas em linguagem natural que especificam as propriedades moleculares desejadas. Ele alterna automaticamente entre o LLM básico e os módulos de IA baseados em gráficos para projetar a molécula, explicar a lógica e gerar um plano passo a passo para sintetizá-la. Ele intercala texto, gráfico e geração de etapas de síntese, combinando palavras, gráficos e reações em um vocabulário comum para o LLM consumir.

Quando comparada às abordagens existentes baseadas em LLM, essa técnica multimodal gerou moléculas que correspondiam melhor às especificações do usuário e tinham maior probabilidade de ter um plano de síntese válido, melhorando a taxa de sucesso de 5% para 35%.

Ele também superou LLMs que são mais de 10 vezes maiores que seu tamanho e que projetam moléculas e rotas de síntese apenas com representações baseadas em texto, sugerindo que a multimodalidade é a chave para o sucesso do novo sistema.

"Esperamos que esta possa ser uma solução completa, onde, do início ao fim, automatizaríamos todo o processo de concepção e fabricação de uma molécula. Se um LLM pudesse fornecer a resposta em poucos segundos, seria uma enorme economia de tempo para as empresas farmacêuticas", afirma Michael Sun, aluno de pós-graduação do MIT e coautor de um artigo sobre essa técnica.

Os coautores de Sun incluem o autor principal Gang Liu, estudante de pós-graduação da Universidade de Notre Dame; Wojciech Matusik, professor de engenharia elétrica e ciência da computação do MIT, que lidera o Grupo de Design e Fabricação Computacional do Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL); Meng Jiang, professora associada da Universidade de Notre Dame; e o autor sênior Jie Chen, pesquisador sênior e gerente do Laboratório de IA Watson do MIT-IBM. A pesquisa será apresentada na Conferência Internacional sobre Representações de Aprendizagem.

O melhor dos dois mundos

Grandes modelos de linguagem não são criados para entender as nuances da química, o que é um dos motivos pelos quais eles têm dificuldades com o design molecular inverso, um processo de identificação de estruturas moleculares que têm certas funções ou propriedades.

Os LLMs convertem texto em representações chamadas tokens, que usam para prever sequencialmente a próxima palavra em uma frase. Mas as moléculas são "estruturas de grafos", compostas por átomos e ligações sem nenhuma ordem específica, o que as torna difíceis de codificar como texto sequencial.

Por outro lado, modelos poderosos de IA baseados em gráficos representam átomos e ligações moleculares como nós e arestas interconectados em um gráfico. Embora esses modelos sejam populares para design molecular inverso, eles exigem entradas complexas, não conseguem entender a linguagem natural e produzem resultados que podem ser difíceis de interpretar.

Os pesquisadores do MIT combinaram um LLM com modelos de IA baseados em gráficos em uma estrutura unificada que reúne o melhor dos dois mundos.

Llamole, sigla em inglês para modelo de grande linguagem para descoberta molecular, usa um LLM base como um guardião para entender a consulta de um usuário — uma solicitação em linguagem simples para uma molécula com certas propriedades.

Por exemplo, talvez um usuário procure uma molécula que possa penetrar a barreira hematoencefálica e inibir o HIV, dado que ela tem um peso molecular de 209 e certas características de ligação.

À medida que o LLM prevê texto em resposta à consulta, ele alterna entre módulos de gráfico.

Um módulo utiliza um modelo de difusão em grafos para gerar a estrutura molecular condicionada aos requisitos de entrada. Um segundo módulo utiliza uma rede neural em grafos para codificar a estrutura molecular gerada de volta em tokens para os LLMs consumirem. O último módulo em grafos é um preditor de reações em grafos que recebe como entrada uma estrutura molecular intermediária e prevê uma etapa da reação, buscando o conjunto exato de etapas para formar a molécula a partir de blocos de construção básicos.

Os pesquisadores criaram um novo tipo de token de gatilho que informa ao LLM quando ativar cada módulo. Quando o LLM prevê um token de gatilho de "design", ele alterna para o módulo que esboça uma estrutura molecular e, quando prevê um token de gatilho "retro", alterna para o módulo de planejamento retrossintético que prevê a próxima etapa da reação.

"A beleza disso é que tudo o que o LLM gera antes de ativar um módulo específico é alimentado para o próprio módulo. O módulo está aprendendo a operar de uma forma consistente com o que existia antes", diz Sun.

Da mesma forma, a saída de cada módulo é codificada e realimentada no processo de geração do LLM, para que ele entenda o que cada módulo fez e continue prevendo tokens com base nesses dados.

Estruturas moleculares melhores e mais simples

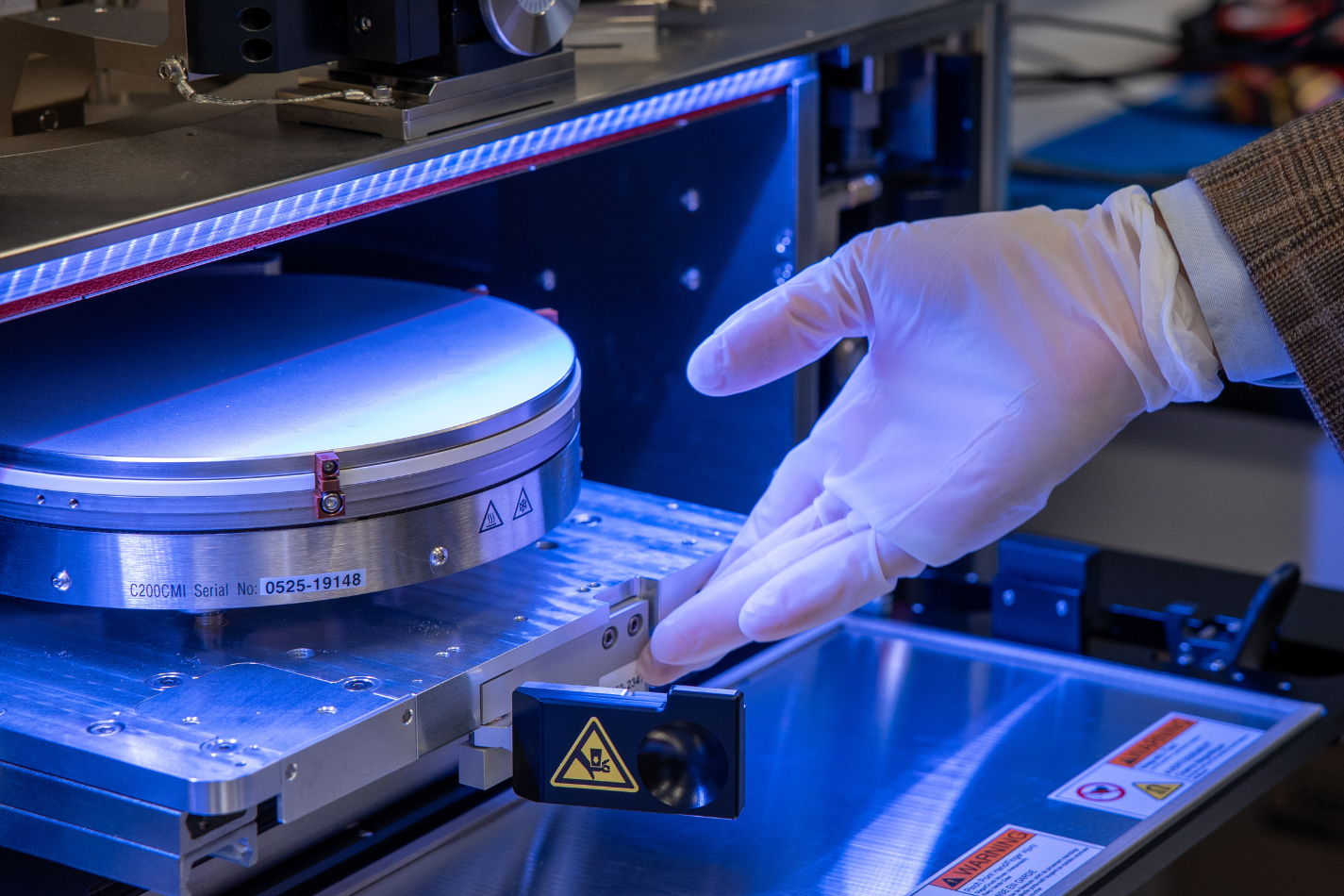

No final, o Llamole gera uma imagem da estrutura molecular, uma descrição textual da molécula e um plano de síntese passo a passo que fornece detalhes de como fazê-la, até mesmo reações químicas individuais.

Em experimentos envolvendo o desenvolvimento de moléculas que correspondiam às especificações do usuário, o Llamole superou 10 LLMs padrão, quatro LLMs com ajuste fino e um método de domínio específico de última geração. Ao mesmo tempo, aumentou a taxa de sucesso do planejamento retrossintético de 5% para 35%, gerando moléculas de maior qualidade, o que significa que tinham estruturas mais simples e blocos de construção de menor custo.

"Sozinhos, os LLMs têm dificuldade em descobrir como sintetizar moléculas, pois isso exige muito planejamento em várias etapas. Nosso método pode gerar estruturas moleculares melhores, que também são mais fáceis de sintetizar", diz Liu.

Para treinar e avaliar o Llamole, os pesquisadores construíram dois conjuntos de dados do zero, já que os conjuntos de dados existentes sobre estruturas moleculares não continham detalhes suficientes. Eles complementaram centenas de milhares de moléculas patenteadas com descrições em linguagem natural geradas por IA e modelos de descrição personalizados.

O conjunto de dados que eles criaram para ajustar o LLM inclui modelos relacionados a 10 propriedades moleculares, então uma limitação do Llamole é que ele é treinado para projetar moléculas considerando apenas essas 10 propriedades numéricas.

Em trabalhos futuros, os pesquisadores pretendem generalizar o Llamole para que ele possa incorporar qualquer propriedade molecular. Além disso, planejam aprimorar os módulos gráficos para aumentar a taxa de sucesso da retrossíntese do Llamole.

E, a longo prazo, eles esperam usar essa abordagem para ir além das moléculas, criando LLMs multimodais que podem lidar com outros tipos de dados baseados em gráficos, como sensores interconectados em uma rede elétrica ou transações em um mercado financeiro.

“Llamole demonstra a viabilidade de usar grandes modelos de linguagem como uma interface para dados complexos além da descrição textual, e prevemos que eles sejam uma base que interage com outros algoritmos de IA para resolver quaisquer problemas de gráficos”, diz Chen.

Esta pesquisa é financiada, em parte, pelo MIT-IBM Watson AI Lab, pela National Science Foundation e pelo Office of Naval Research.