Tecnologia Científica

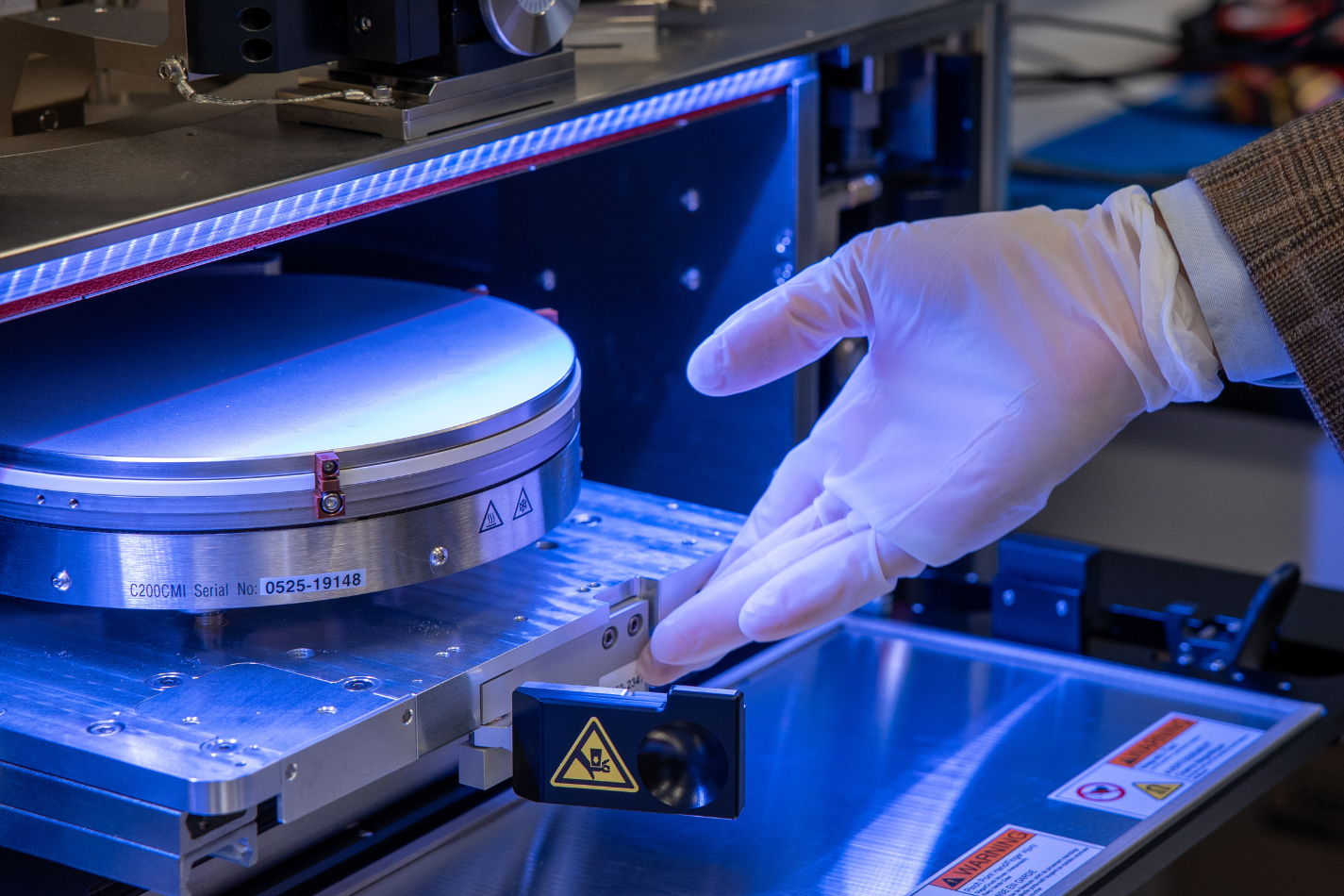

O sistema permite que robôs identifiquem as propriedades de um objeto por meio do manuseio

Com um novo método de simulação, robôs podem estimar o peso, a maciez e outras propriedades físicas de um objeto apenas pegando-o.

Com um novo método de simulação, robôs podem estimar o peso, a maciez e outras propriedades físicas de um objeto apenas pegando-o. Crédito: MIT News, iStock

Um humano limpando o lixo de um sótão muitas vezes consegue adivinhar o conteúdo de uma caixa simplesmente pegando-a e sacudindo-a, sem precisar ver o que há dentro. Pesquisadores do MIT, da Amazon Robotics e da Universidade da Colúmbia Britânica ensinaram robôs a fazer algo semelhante.

Eles desenvolveram uma técnica que permite que robôs usem apenas sensores internos para aprender sobre o peso, a maciez ou o conteúdo de um objeto, pegando-o e sacudindo-o suavemente. Com esse método, que não requer ferramentas de medição externas ou câmeras, o robô consegue estimar com precisão parâmetros como a massa de um objeto em questão de segundos.

Essa técnica de baixo custo pode ser especialmente útil em aplicações onde as câmeras podem ser menos eficazes, como classificar objetos em um porão escuro ou limpar escombros dentro de um prédio que desabou parcialmente após um terremoto.

A chave para sua abordagem é um processo de simulação que incorpora modelos do robô e do objeto para identificar rapidamente as características desse objeto enquanto o robô interage com ele.

A técnica dos pesquisadores é tão eficaz em estimar a massa de um objeto quanto alguns métodos mais complexos e caros que incorporam visão computacional. Além disso, sua abordagem, com uso eficiente de dados, é robusta o suficiente para lidar com diversos tipos de cenários inéditos.

“Essa ideia é geral, e acredito que estamos apenas arranhando a superfície do que um robô pode aprender dessa forma. Meu sonho seria ter robôs saindo pelo mundo, tocando e movendo coisas em seus ambientes, e descobrindo sozinhos as propriedades de tudo com que interagem”, diz Peter Yichen Chen, pós-doutorando do MIT e autor principal de um artigo sobre essa técnica .

Seus coautores incluem Chao Liu, colega de pós-doutorado do MIT; Pingchuan Ma, PhD '25; Jack Eastman, MEng '24; Dylan Randle e Yuri Ivanov, da Amazon Robotics; Daniela Rus, professora de engenharia elétrica e ciência da computação do MIT, que lidera o Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL) do MIT; e Wojciech Matusik, que lidera o Grupo de Design e Fabricação Computacional do CSAIL. A pesquisa será apresentada na Conferência Internacional sobre Robótica e Automação.

Sinais de detecção

O método dos pesquisadores aproveita a propriocepção, que é a capacidade de um ser humano ou robô de sentir seu movimento ou posição no espaço.

Por exemplo, um humano que levanta um haltere na academia consegue sentir o peso desse haltere no pulso e no bíceps, mesmo segurando o haltere na mão. Da mesma forma, um robô consegue "sentir" o peso de um objeto através das múltiplas articulações do seu braço.

"Um humano não tem medições superprecisas dos ângulos das articulações dos dedos ou da quantidade exata de torque que aplicamos a um objeto, mas um robô tem. Nós aproveitamos essas habilidades", diz Liu.

À medida que o robô levanta um objeto, o sistema dos pesquisadores coleta sinais dos codificadores de articulações do robô, que são sensores que detectam a posição rotacional e a velocidade de suas articulações durante o movimento.

A maioria dos robôs possui codificadores de juntas dentro dos motores que acionam suas partes móveis, acrescenta Liu. Isso torna a técnica mais econômica do que algumas abordagens, pois dispensa componentes extras, como sensores táteis ou sistemas de rastreamento visual.

Para estimar as propriedades de um objeto durante as interações robô-objeto, o sistema se baseia em dois modelos: um que simula o robô e seu movimento e outro que simula a dinâmica do objeto.

“Ter um gêmeo digital preciso do mundo real é muito importante para o sucesso do nosso método”, acrescenta Chen.

O algoritmo deles “observa” o robô e o objeto se moverem durante uma interação física e usa dados do codificador conjunto para trabalhar de trás para frente e identificar as propriedades do objeto.

Por exemplo, um objeto mais pesado se moverá mais lentamente que um leve se o robô aplicar a mesma quantidade de força.

Simulações diferenciáveis

Eles utilizam uma técnica chamada simulação diferenciável, que permite ao algoritmo prever como pequenas mudanças nas propriedades de um objeto, como massa ou maciez, impactam a posição final da articulação do robô. Os pesquisadores construíram suas simulações usando a biblioteca Warp da NVIDIA, uma ferramenta de desenvolvimento de código aberto que suporta simulações diferenciáveis.

Assim que a simulação diferenciável corresponde aos movimentos reais do robô, o sistema identifica a propriedade correta. O algoritmo consegue fazer isso em questão de segundos e precisa apenas ver uma trajetória real do robô em movimento para realizar os cálculos.

“Tecnicamente, contanto que você conheça o modelo do objeto e como o robô pode aplicar força a ele, você deve ser capaz de descobrir o parâmetro que deseja identificar”, diz Liu.

Os pesquisadores usaram seu método para aprender a massa e a maciez de um objeto, mas sua técnica também pode determinar propriedades como o momento de inércia ou a viscosidade de um fluido dentro de um recipiente.

Além disso, como seu algoritmo não precisa de um amplo conjunto de dados para treinamento, como alguns métodos que dependem de visão computacional ou sensores externos, ele não seria tão suscetível a falhas quando confrontado com ambientes desconhecidos ou novos objetos.

No futuro, os pesquisadores querem tentar combinar seu método com visão computacional para criar uma técnica de detecção multimodal ainda mais poderosa.

“Este trabalho não pretende substituir a visão computacional. Ambos os métodos têm seus prós e contras. Mas aqui mostramos que, sem uma câmera, já conseguimos descobrir algumas dessas propriedades”, diz Chen.

Eles também querem explorar aplicações com sistemas robóticos mais complicados, como robôs macios, e objetos mais complexos, incluindo líquidos que chacoalham ou meios granulares como areia.

A longo prazo, eles esperam aplicar essa técnica para melhorar o aprendizado dos robôs, permitindo que futuros robôs desenvolvam rapidamente novas habilidades de manipulação e se adaptem às mudanças em seus ambientes.

"Determinar as propriedades físicas de objetos a partir de dados tem sido um desafio na robótica há muito tempo, especialmente quando apenas medições limitadas ou com ruído estão disponíveis. Este trabalho é significativo porque mostra que robôs podem inferir com precisão propriedades como massa e maciez usando apenas seus sensores internos nas juntas, sem depender de câmeras externas ou ferramentas de medição especializadas", afirma Miles Macklin, diretor sênior de tecnologia de simulação da NVIDIA, que não participou desta pesquisa.

Este trabalho é financiado, em parte, pela Amazon e pelo Programa de Pesquisa GIST-CSAIL.