Tecnologia Científica

Uma nova maneira de editar ou gerar imagens

Pesquisadores do MIT descobriram que tipos especiais de redes neurais, chamados codificadores ou “tokenizadores”, podem fazer muito mais do que se imaginava anteriormente.

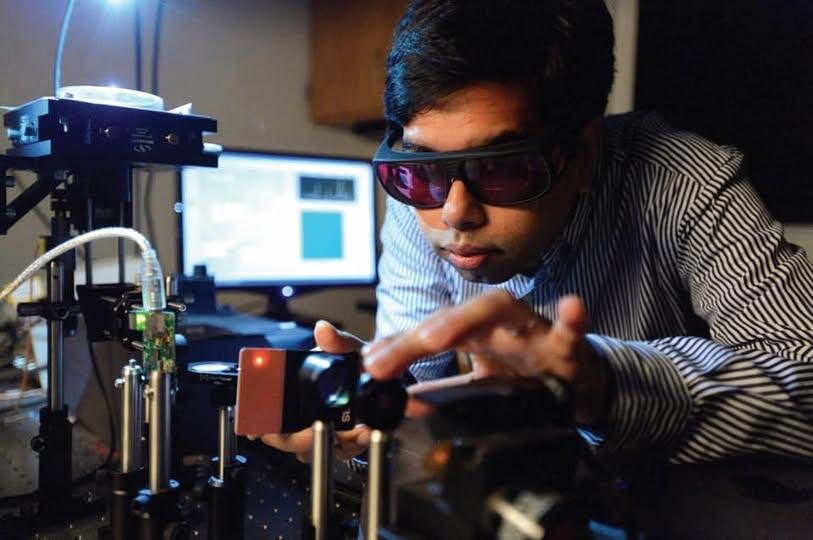

Um sistema capaz de gerar imagens normalmente requer um tokenizador, que comprime e codifica dados visuais, juntamente com um gerador capaz de combinar e organizar essas representações compactas para criar imagens originais. Pesquisadores do MIT descobriram um novo método para criar, converter e "pintar" imagens sem usar um gerador. Esta imagem mostra como uma imagem de entrada pode ser gradualmente modificada pela otimização de tokens. Créditos: Imagem cortesia dos autores.

A geração de imagens por IA — que se baseia em redes neurais para criar novas imagens a partir de uma variedade de entradas, incluindo prompts de texto — deverá se tornar uma indústria bilionária até o final desta década. Mesmo com a tecnologia atual, se você quisesse criar uma imagem fantástica de, digamos, um amigo fincando uma bandeira em Marte ou voando descuidadamente para dentro de um buraco negro, isso levaria menos de um segundo. No entanto, antes que pudessem realizar tarefas como essa, os geradores de imagens são comumente treinados em conjuntos de dados massivos contendo milhões de imagens, frequentemente emparelhadas com texto associado. Treinar esses modelos generativos pode ser uma tarefa árdua que leva semanas ou meses, consumindo vastos recursos computacionais no processo.

Mas e se fosse possível gerar imagens por meio de métodos de IA sem usar um gerador? Essa possibilidade real, juntamente com outras ideias intrigantes, foi descrita em um artigo de pesquisa apresentado na Conferência Internacional sobre Aprendizado de Máquina (ICML 2025), realizada em Vancouver, Colúmbia Britânica, no início deste verão. O artigo, que descreve novas técnicas para manipulação e geração de imagens, foi escrito por Lukas Lao Beyer, pesquisador de pós-graduação no Laboratório de Sistemas de Informação e Decisão (LIDS) do MIT; Tianhong Li, pós-doutorado no Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL) do MIT; Xinlei Chen, da Facebook AI Research; Sertac Karaman, professor de aeronáutica e astronáutica do MIT e diretor do LIDS; e Kaiming He, professor associado de engenharia elétrica e ciência da computação do MIT.

Esse esforço em grupo teve origem em um projeto de classe para um seminário de pós-graduação sobre modelos generativos profundos, realizado por Lao Beyer no último outono. Em conversas durante o semestre, tornou-se evidente para Lao Beyer e He, que ministrava o seminário, que essa pesquisa tinha um potencial real, que ia muito além dos limites de uma tarefa de casa típica. Outros colaboradores logo foram incorporados à iniciativa.

O ponto de partida para a investigação de Lao Beyer foi um artigo de junho de 2024, escrito por pesquisadores da Universidade Técnica de Munique e da empresa chinesa ByteDance, que apresentou uma nova maneira de representar informações visuais chamada tokenizador unidimensional. Com esse dispositivo, que também é uma espécie de rede neural, uma imagem de 256x256 pixels pode ser traduzida em uma sequência de apenas 32 números, chamados tokens. "Eu queria entender como um nível tão alto de compressão poderia ser alcançado e o que os próprios tokens realmente representavam", diz Lao Beyer.

A geração anterior de tokenizadores normalmente dividia a mesma imagem em uma matriz de tokens de 16x16 — com cada token encapsulando informações, de forma altamente condensada, que correspondem a uma parte específica da imagem original. Os novos tokenizadores 1D podem codificar uma imagem com mais eficiência, usando muito menos tokens no geral, e esses tokens são capazes de capturar informações sobre a imagem inteira, não apenas sobre um único quadrante. Cada um desses tokens, além disso, é um número de 12 dígitos composto por 1s e 0s, permitindo 2 12 (ou cerca de 4.000) possibilidades no total. "É como um vocabulário de 4.000 palavras que compõe uma linguagem abstrata e oculta falada pelo computador", explica ele. "Não é como uma linguagem humana, mas ainda podemos tentar descobrir o que significa."

Foi exatamente isso que Lao Beyer se propôs a explorar inicialmente — um trabalho que forneceu a semente para o artigo do ICML 2025. A abordagem que ele adotou foi bastante direta. Se você quiser descobrir o que um token específico faz, diz Lao Beyer, "você pode simplesmente retirá-lo, substituir por algum valor aleatório e ver se há uma mudança reconhecível na saída". A substituição de um token, ele descobriu, altera a qualidade da imagem, transformando uma imagem de baixa resolução em uma imagem de alta resolução ou vice-versa. Outro token afetava o desfoque no fundo, enquanto outro ainda influenciava o brilho. Ele também encontrou um token relacionado à "pose", o que significa que, na imagem de um tordo, por exemplo, a cabeça do pássaro pode se mover da direita para a esquerda.

“Este foi um resultado inédito, pois ninguém havia observado alterações visualmente identificáveis na manipulação de tokens”, afirma Lao Beyer. A descoberta levantou a possibilidade de uma nova abordagem para a edição de imagens. E o grupo do MIT demonstrou, de fato, como esse processo pode ser simplificado e automatizado, para que os tokens não precisem ser modificados manualmente, um de cada vez.

Ele e seus colegas alcançaram um resultado ainda mais consequente envolvendo a geração de imagens. Um sistema capaz de gerar imagens normalmente requer um tokenizador, que comprime e codifica dados visuais, juntamente com um gerador capaz de combinar e organizar essas representações compactas para criar imagens inéditas. Os pesquisadores do MIT encontraram uma maneira de criar imagens sem usar um gerador. Sua nova abordagem utiliza um tokenizador unidimensional e um chamado destokenizador (também conhecido como decodificador), que pode reconstruir uma imagem a partir de uma sequência de tokens. No entanto, com a orientação fornecida por uma rede neural pronta para uso chamada CLIP — que não consegue gerar imagens por si só, mas pode medir o quão bem uma determinada imagem corresponde a um determinado prompt de texto — a equipe conseguiu converter a imagem de um panda-vermelho, por exemplo, em um tigre. Além disso, eles conseguiram criar imagens de um tigre, ou de qualquer outra forma desejada, começando completamente do zero — a partir de uma situação em que todos os tokens recebem inicialmente valores aleatórios (e depois são ajustados iterativamente para que a imagem reconstruída corresponda cada vez mais ao prompt de texto desejado).

O grupo demonstrou que, com a mesma configuração — utilizando um tokenizador e um destokenizador, mas sem um gerador —, também seria possível realizar "pintura interna", o que significa preencher partes de imagens que, de alguma forma, haviam sido apagadas. Evitar o uso de um gerador para determinadas tarefas poderia levar a uma redução significativa nos custos computacionais, pois os geradores, como mencionado, normalmente exigem treinamento extensivo.

O que pode parecer estranho nas contribuições desta equipe, explica ele, "é que não inventamos nada de novo. Não inventamos um tokenizador 1D, nem inventamos o modelo CLIP. Mas descobrimos que novas capacidades podem surgir quando juntamos todas essas peças".

“Este trabalho redefine o papel dos tokenizadores”, comenta Saining Xie, cientista da computação da Universidade de Nova York. “Ele mostra que os tokenizadores de imagens — ferramentas geralmente usadas apenas para compactar imagens — podem, na verdade, fazer muito mais. O fato de um tokenizador 1D simples (mas altamente compactado) conseguir lidar com tarefas como pintura interna ou edição guiada por texto, sem a necessidade de treinar um modelo generativo completo, é bastante surpreendente.”

Zhuang Liu, da Universidade de Princeton, concorda, afirmando que o trabalho do grupo do MIT "mostra que podemos gerar e manipular imagens de uma forma muito mais fácil do que pensávamos anteriormente. Basicamente, demonstra que a geração de imagens pode ser um subproduto de um compressor de imagens muito eficaz, reduzindo potencialmente o custo de geração de imagens em várias vezes".

Pode haver muitas aplicações fora do campo da visão computacional, sugere Karaman. "Por exemplo, poderíamos considerar tokenizar as ações de robôs ou carros autônomos da mesma forma, o que pode ampliar rapidamente o impacto deste trabalho."

Lao Beyer pensa de forma semelhante, observando que a extrema compressão proporcionada pelos tokenizadores unidimensionais permite fazer "coisas incríveis", que poderiam ser aplicadas a outros campos. Por exemplo, na área de carros autônomos, que é um de seus interesses de pesquisa, os tokens poderiam representar, em vez de imagens, as diferentes rotas que um veículo poderia percorrer.

Xie também está intrigado com as aplicações que essas ideias inovadoras podem gerar. "Há alguns casos de uso muito interessantes que isso pode gerar", diz ele.