Tecnologia Científica

Grandes modelos de linguagem podem descobrir o mundo real?

Um novo teste pode ajudar a determinar se os sistemas de IA que fazem previsões precisas em uma área conseguem entendê-la bem o suficiente para aplicar essa capacidade a uma área diferente.

Pesquisadores do MIT e da Universidade de Harvard desenvolveram uma nova abordagem para avaliar o quão profundamente os sistemas de IA preditiva entendem seu assunto e se eles podem aplicar o conhecimento de um domínio a outro ligeiramente diferente. Créditos: Imagem: iStock

No século XVII, o astrônomo alemão Johannes Kepler desvendou as leis do movimento que permitiam prever com precisão a posição dos planetas do nosso sistema solar no céu enquanto orbitavam o Sol. Mas foi somente décadas depois, quando Isaac Newton formulou as leis universais da gravitação, que os princípios subjacentes foram compreendidos. Embora inspiradas nas leis de Kepler, elas foram muito além e possibilitaram a aplicação das mesmas fórmulas a tudo, desde a trajetória de uma bala de canhão até a forma como a força de atração da Lua controla as marés na Terra — ou como lançar um satélite da Terra para a superfície da Lua ou dos planetas.

Os sofisticados sistemas de inteligência artificial atuais tornaram-se muito bons em fazer o tipo de previsões específicas que se assemelham às previsões orbitais de Kepler. Mas será que eles sabem por que essas previsões funcionam, com o tipo de compreensão profunda que advém de princípios básicos como as leis de Newton? À medida que o mundo se torna cada vez mais dependente desses tipos de sistemas de IA, os pesquisadores lutam para tentar mensurar exatamente como eles fazem o que fazem e quão profunda é sua compreensão do mundo real.

Agora, pesquisadores do Laboratório de Sistemas de Informação e Decisão (LIDS) do MIT e da Universidade Harvard desenvolveram uma nova abordagem para avaliar o quão profundamente esses sistemas preditivos compreendem seu objeto de estudo e se conseguem aplicar o conhecimento de um domínio a outro ligeiramente diferente. E, de modo geral, a resposta, neste ponto, nos exemplos que estudaram, é — nem tanto.

As descobertas foram apresentadas na Conferência Internacional sobre Aprendizado de Máquina, em Vancouver, Colúmbia Britânica, no mês passado, pelo pós-doutorado de Harvard Keyon Vafa, pelo aluno de pós-graduação do MIT em engenharia elétrica e ciência da computação e afiliado do LIDS Peter G. Chang, pelo professor assistente do MIT e pesquisador principal do LIDS Ashesh Rambachan, e pelo professor do MIT, pesquisador principal do LIDS e autor sênior Sendhil Mullainathan.

“Os humanos sempre foram capazes de fazer essa transição de boas previsões para modelos de mundo”, diz Vafa, principal autor do estudo. Portanto, a questão que a equipe estava abordando era: “os modelos de base — a IA — foram capazes de dar esse salto de previsões para modelos de mundo? E não estamos perguntando se eles são capazes, se podem ou se farão. A questão é: eles já fizeram isso até agora?”, diz ele.

“Sabemos como testar se um algoritmo prevê bem. Mas o que precisamos é de uma maneira de testar se ele compreendeu bem”, diz Mullainathan, professor da cátedra Peter de Florez com dupla nomeação nos departamentos de Economia e Engenharia Elétrica e Ciência da Computação do MIT e autor sênior do estudo. “Até mesmo definir o que significa compreender foi um desafio.”

Na analogia entre Kepler e Newton, Vafa afirma: "ambos tinham modelos que funcionavam muito bem em uma tarefa e que funcionavam essencialmente da mesma forma naquela tarefa. O que Newton oferecia eram ideias que podiam ser generalizadas para novas tarefas". Essa capacidade, quando aplicada às previsões feitas por vários sistemas de IA, implicaria que ele desenvolvesse um modelo mundial que pudesse "transcender a tarefa em que você está trabalhando e ser capaz de generalizar para novos tipos de problemas e paradigmas".

Outra analogia que ajuda a ilustrar o ponto é a diferença entre séculos de conhecimento acumulado sobre como criar seletivamente plantações e animais, versus a percepção de Gregor Mendel sobre as leis subjacentes da herança genética.

“Há muito entusiasmo na área sobre o uso de modelos de base não apenas para executar tarefas, mas para aprender algo sobre o mundo”, por exemplo, nas ciências naturais, diz ele. “Seria necessário se adaptar, ter um modelo de mundo para se adaptar a qualquer tarefa possível.”

Os sistemas de IA estão perto da capacidade de alcançar tais generalizações? Para testar a questão, a equipe analisou diferentes exemplos de sistemas de IA preditiva, em diferentes níveis de complexidade. Nos exemplos mais simples, os sistemas conseguiram criar um modelo realista do sistema simulado, mas, à medida que os exemplos se tornaram mais complexos, essa capacidade diminuiu rapidamente.

A equipe desenvolveu uma nova métrica, uma forma de medir quantitativamente o quão bem um sistema se aproxima das condições do mundo real. Eles chamam essa medição de viés indutivo — ou seja, uma tendência ou viés em direção a respostas que refletem a realidade, com base em inferências desenvolvidas a partir da análise de grandes quantidades de dados sobre casos específicos.

O nível mais simples de exemplos que eles analisaram era conhecido como modelo de rede. Em uma rede unidimensional, algo pode se mover apenas ao longo de uma linha. Vafa compara isso a um sapo pulando entre vitórias-régias em uma fileira. Conforme o sapo pula ou senta, ele grita o que está fazendo — direita, esquerda ou ficar. Se ele alcança a última vitória-régia na fileira, ele só pode ficar ou voltar. Se alguém, ou um sistema de IA, pode apenas ouvir os chamados, sem saber nada sobre o número de vitórias-régias, ele pode descobrir a configuração? A resposta é sim: modelos preditivos funcionam bem em reconstruir o "mundo" em um caso tão simples. Mas mesmo com redes, à medida que você aumenta o número de dimensões, os sistemas não conseguem mais dar esse salto.

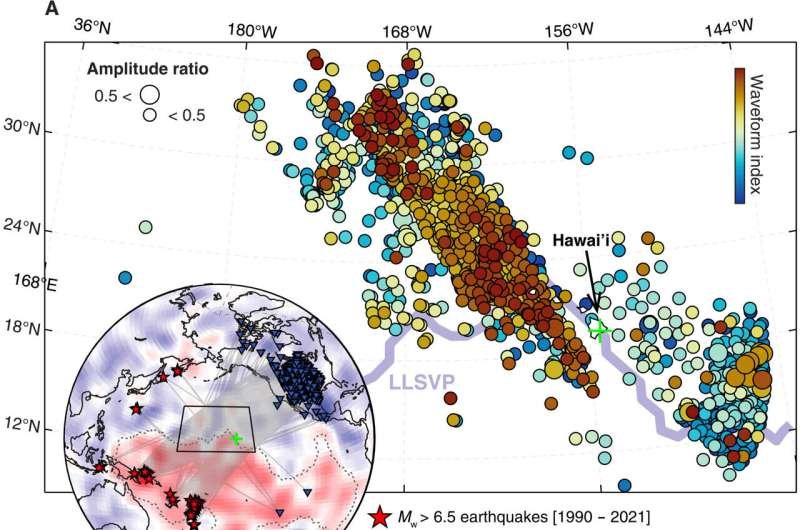

“Por exemplo, em uma rede de dois ou três estados, mostramos que o modelo tem um viés indutivo bastante bom em relação ao estado real”, diz Chang. “Mas, à medida que aumentamos o número de estados, ele começa a divergir dos modelos do mundo real.”

Um problema mais complexo é um sistema que permite jogar o jogo de tabuleiro Otelo, que envolve jogadores posicionando discos pretos ou brancos alternadamente em uma grade. Os modelos de IA conseguem prever com precisão quais movimentos são permitidos em um determinado momento, mas eles não conseguem inferir qual é a disposição geral das peças no tabuleiro, incluindo aquelas que estão bloqueadas no momento.

A equipe então analisou cinco categorias diferentes de modelos preditivos realmente em uso e, novamente, quanto mais complexos os sistemas envolvidos, pior o desempenho dos modos preditivos em corresponder ao verdadeiro modelo do mundo subjacente.

Com essa nova métrica de viés indutivo, "nossa esperança é fornecer uma espécie de banco de testes onde seja possível avaliar diferentes modelos, diferentes abordagens de treinamento, em problemas em que sabemos qual é o verdadeiro modelo do mundo", diz Vafa. Se o desempenho for bom nesses casos em que já conhecemos a realidade subjacente, podemos ter mais confiança de que suas previsões podem ser úteis mesmo em casos "em que não sabemos realmente qual é a verdade", diz ele.

As pessoas já estão tentando usar esses tipos de sistemas de IA preditiva para auxiliar em descobertas científicas, incluindo aspectos como propriedades de compostos químicos que nunca foram realmente criados, ou de potenciais compostos farmacêuticos, ou para prever o comportamento de dobramento e as propriedades de moléculas de proteína desconhecidas. "Para problemas mais realistas", diz Vafa, "mesmo para algo como mecânica básica, descobrimos que parece haver um longo caminho a percorrer."

Chang diz: "Tem havido muita publicidade em torno de modelos de base, onde as pessoas estão tentando construir modelos de base específicos de domínio — modelos de base baseados em biologia, modelos de base baseados em física, modelos de base de robótica, modelos de base para outros tipos de domínios onde as pessoas têm coletado uma tonelada de dados" e treinado esses modelos para fazer previsões, "e então esperando que eles adquiram algum conhecimento do próprio domínio, para serem usados ??em outras tarefas posteriores".

Este trabalho mostra que há um longo caminho a percorrer, mas também ajuda a apontar um caminho a seguir. "Nosso artigo sugere que podemos aplicar nossas métricas para avaliar o quanto a representação está aprendendo, para que possamos encontrar melhores maneiras de treinar modelos básicos, ou pelo menos avaliar os modelos que estamos treinando atualmente", diz Chang. "Como área da engenharia, quando temos uma métrica para algo, as pessoas são muito, muito boas em otimizá-la."