Tecnologia Científica

O ChatGPT parecia 'pensar rapidamente' quando submetido a um quebra-cabeça matemático da Grécia Antiga

O chatbot de inteligência artificial, ChatGPT, pareceu improvisar ideias e cometer erros como um aluno em um estudo que reiniciou um desafio matemático de 2.400 anos.

Apesar de "conhecer" a famosa solução geométrica que Sócrates (esquerda) deu para dobrar o tamanho de qualquer quadrado (direita), o ChatGPT preferia sua própria abordagem idiossincrática, descobriram os pesquisadores. Crédito: Greg O'Bairne, licença CC-BY-SA 3.0, via Wikimedia Commons / Nada

Ao contrário das provas encontradas em livros didáticos confiáveis, os alunos não podem presumir que as provas do Chat GPT são válidas

Andreas Stylianides

O experimento, realizado por dois pesquisadores em educação, pediu ao chatbot que resolvesse uma versão do problema de "dobrar o quadrado" – uma lição descrita por Platão por volta de 385 a.C. e, segundo o artigo, "talvez o experimento mais antigo documentado em educação matemática". O quebra-cabeça desencadeou séculos de debate sobre se o conhecimento está latente em nós, esperando para ser "recuperado", ou se é algo que "geramos" por meio de experiências e encontros vividos.

O novo estudo explorou uma questão semelhante sobre o "conhecimento" matemático do ChatGPT – como este pode ser percebido por seus usuários. Os pesquisadores queriam saber se ele resolveria o problema de Platão usando o conhecimento que já "possuía" ou desenvolvendo adaptativamente suas próprias soluções.

Platão descreve Sócrates ensinando um menino sem instrução a dobrar a área de um quadrado. A princípio, o menino sugere erroneamente dobrar o comprimento de cada lado, mas Sócrates eventualmente o leva a entender que os lados do novo quadrado devem ter o mesmo comprimento que a diagonal do original.

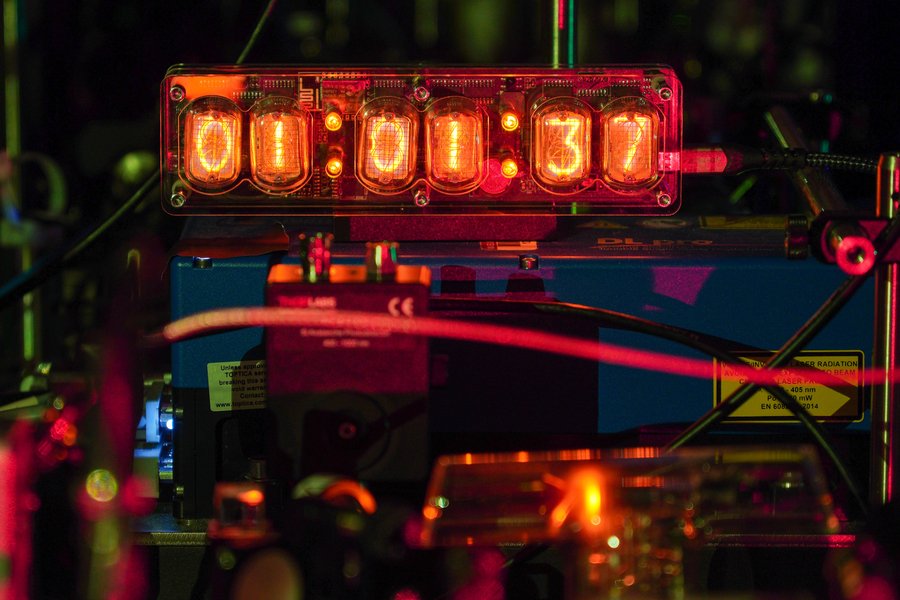

Os pesquisadores colocaram esse problema no ChatGPT-4, primeiro imitando as perguntas de Sócrates e depois introduzindo deliberadamente erros, consultas e novas variantes do problema.

Assim como outros Modelos de Grandes Linguagens (LLMs), o ChatGPT é treinado em vastas coleções de texto e gera respostas prevendo sequências de palavras aprendidas durante o treinamento. Os pesquisadores esperavam que ele lidasse com o desafio matemático da Grécia Antiga regurgitando seu "conhecimento" preexistente da famosa solução de Sócrates. Em vez disso, porém, ele pareceu improvisar sua abordagem e, em determinado momento, também cometeu um erro nitidamente humano.

O estudo foi conduzido pelo Dr. Nadav Marco, pesquisador visitante da Universidade de Cambridge, e Andreas Stylianides, professor de Educação Matemática em Cambridge. Marco trabalha permanentemente na Universidade Hebraica e na Faculdade de Educação David Yellin, em Jerusalém.

Embora sejam cautelosos sobre os resultados, enfatizando que os LLMs não pensam como humanos ou "resolvem as coisas", Marco caracterizou o comportamento do ChatGPT como "semelhante ao de um aprendiz".

“Quando enfrentamos um novo problema, nosso instinto geralmente é testar soluções com base em nossa experiência passada”, disse Marco. “Em nosso experimento, o ChatGPT pareceu fazer algo semelhante. Como um aluno ou acadêmico, ele pareceu apresentar suas próprias hipóteses e soluções.”

Como o ChatGPT é treinado em texto e não em diagramas, ele tende a ser mais fraco no tipo de raciocínio geométrico que Sócrates usou no problema da duplicação do quadrado. Apesar disso, o texto de Platão é tão conhecido que os pesquisadores esperavam que o chatbot reconhecesse suas perguntas e reproduzisse a solução de Sócrates.

Curiosamente, não conseguiu. Solicitado a dobrar o quadrado, o ChatGPT optou por uma abordagem algébrica desconhecida na época de Platão.

Em seguida, resistiu às tentativas de fazê-lo cometer o erro do menino e teimosamente se ateve à álgebra, mesmo quando os pesquisadores reclamaram que sua resposta era uma aproximação. Somente quando Marco e Stylianides lhe disseram que estavam decepcionados por, apesar de todo o seu treinamento, ele não conseguir fornecer uma resposta "elegante e exata", o Chat apresentou a alternativa geométrica.

Apesar disso, o ChatGPT demonstrou pleno conhecimento da obra de Platão quando questionado sobre ela. "Se estivesse apenas se lembrando de memória, quase certamente teria se referido à solução clássica de construir um novo quadrado diretamente na diagonal do quadrado original", disse Stylianides. "Em vez disso, pareceu adotar sua própria abordagem."

Os pesquisadores também propuseram uma variante do problema de Platão, pedindo ao ChatGPT que dobrasse a área de um retângulo, mantendo suas proporções. Mesmo agora ciente de sua preferência pela geometria, o Chat teimosamente se ateve à álgebra. Quando pressionado, alegou erroneamente que, como a diagonal de um retângulo não pode ser usada para dobrar seu tamanho, uma solução geométrica não estava disponível.

A questão sobre a diagonal é verdadeira, mas existe uma solução geométrica diferente. Marco sugeriu que a chance de essa afirmação falsa ter vindo da base de conhecimento do chatbot era "iminentemente pequena". Em vez disso, o Chat parecia estar improvisando suas respostas com base na discussão anterior sobre o quadrado.

Por fim, Marco e Stylianides pediram que ele dobrasse o tamanho de um triângulo. O Chat voltou à álgebra mais uma vez – mas, após mais insistência, chegou a uma resposta geométrica correta.

Os pesquisadores enfatizam a importância de não interpretar exageradamente esses resultados, visto que não conseguiram observar cientificamente a codificação do Chat. Da perspectiva de sua experiência digital como usuários, no entanto, o que emergiu superficialmente foi uma mistura de recuperação de dados e raciocínio rápido.

Eles comparam esse comportamento ao conceito educacional de "zona de desenvolvimento proximal" (ZDP) – a lacuna entre o que o aluno já sabe e o que ele poderá eventualmente saber com apoio e orientação. Talvez, argumentam, a IA Generativa tenha uma metafórica "ZDP do Chat": em alguns casos, ela não será capaz de resolver problemas imediatamente, mas poderá fazê-lo com estímulos.

Os autores sugerem que trabalhar com o Chat em sua ZDP pode ajudar a transformar suas limitações em oportunidades de aprendizagem. Ao estimular, questionar e testar suas respostas, os alunos não apenas navegarão pelos limites do Chat, mas também desenvolverão as habilidades críticas de avaliação de provas e raciocínio que estão no cerne do pensamento matemático.

“Ao contrário das provas encontradas em livros didáticos respeitáveis, os alunos não podem presumir que as provas do Chat GPT sejam válidas. Compreender e avaliar provas geradas por IA estão emergindo como habilidades essenciais que precisam ser incorporadas ao currículo de matemática”, disse Stylianides.

“Essas são habilidades essenciais que queremos que os alunos dominem, mas isso significa usar instruções como: 'Quero que exploremos esse problema juntos', não: 'Diga-me a resposta'”, acrescentou Marco.

A pesquisa foi publicada no International Journal of Mathematical Education in Science and Technology .