Tecnologia Científica

Como pesquisadores de Stanford projetam sistemas de IA confiáveis e centrados no ser humano

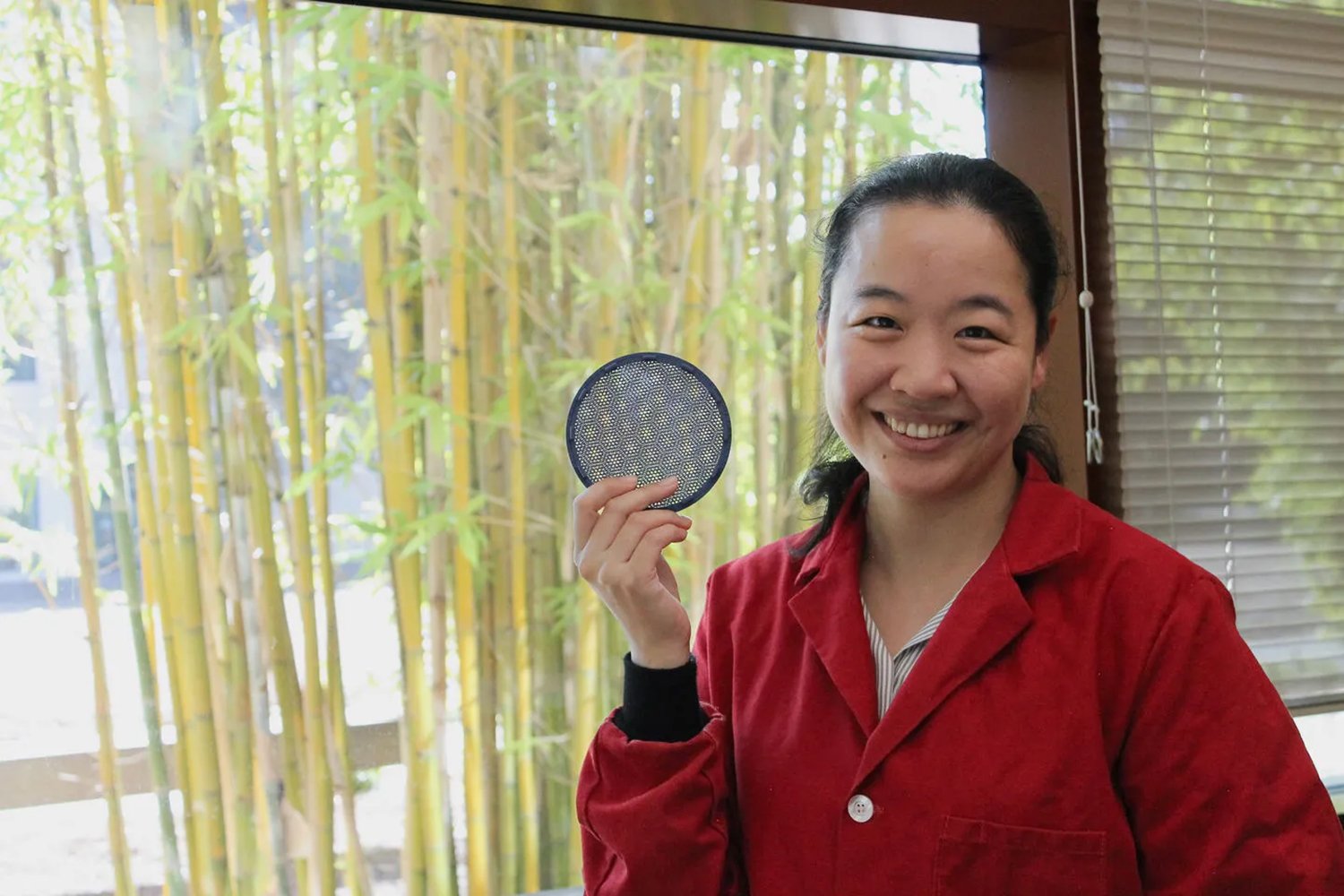

Os cientistas da computação Ludwig Schmidt e Diyi Yang estudam os fundamentos da IA, garantindo que essas ferramentas sejam projetadas pensando nas pessoas.

Diyi Yang e Ludwig Schmidt | Andrew Brodhead; Paul Sakuma/Stanford Ciência de Dados

A inteligência artificial pode parecer mágica, mas os produtos da IA não surgem do nada. Essas ferramentas são construídas com base em algoritmos criados por pessoas para processar e interpretar informações de forma previsível. Muitas ferramentas contêm mais de um algoritmo e, se você deseja obter resultados de alta qualidade da sua IA, os algoritmos devem ser estruturados cuidadosamente, levando em consideração os usuários finais, e treinados com grandes quantidades de dados de alta qualidade.

Aqui, exploramos o trabalho de Ludwig Schmidt e Diyi Yang , dois professores assistentes de ciência da computação na Escola de Engenharia de Stanford, que trabalham na ciência e teoria fundamentais que tornam a IA possível. Com essa responsabilidade em mente, eles buscam aprimorar os conjuntos de dados com os quais os sistemas de IA são treinados, a forma como as pessoas interagem com esses sistemas e os impactos sociais dessa tecnologia.

Suas pesquisas estão fornecendo soluções criativas para perguntas como: Como podemos fazer com que os sistemas de IA funcionem igualmente bem para pessoas que falam idiomas diferentes? O que torna um conjunto de dados de treinamento um "bom" conjunto de dados? Os chatbots de IA podem ajudar a ensinar habilidades sociais às pessoas?

“Queremos construir modelos de IA para humanos”, disse Yang, que lidera o Laboratório de Tecnologias Sociais e de Linguagem , especializado em processamento de linguagem natural com consciência social, grandes modelos de linguagem e interações humano-IA. “Isso significa que nos preocupamos não apenas com as capacidades técnicas desses sistemas, mas também com seu impacto social.”

Dados melhores, IA melhor

A pesquisa de Schmidt aborda o impacto social da IA, trabalhando para aprimorar os conjuntos de dados usados para treinar esses sistemas.

"Grande parte dos dados de treinamento para IA atualmente vem da internet, porque é o único conjunto de dados textuais muito grande que temos", disse Schmidt, especialista em conjuntos de dados de treinamento de IA, modelos de linguagem e multimodalidade (fontes de dados de texto, imagem, áudio e vídeo), e também membro da equipe técnica da Anthropic e da LAION. "Eventualmente, ficaremos sem dados da internet para treinamento, então uma questão importante de pesquisa é descobrir o que faremos quando esses dados de treinamento acabarem."

Schmidt desenvolve as técnicas que organizam conjuntos de dados de treinamento massivos contendo vários trilhões de palavras. Esses conjuntos de dados ensinam os sistemas de IA a operar de forma confiável e segura ao se depararem com novos dados.

"Muitas pessoas estão usando IA em seu trabalho agora porque os modelos começaram a ser úteis", disse Schmidt. “Ao mesmo tempo, os modelos ainda cometem erros que limitam sua utilidade para tarefas mais complexas. Alguns desses erros são devidos a deficiências nos dados de treinamento, e minha pesquisa ajuda a abordar essas deficiências dos modelos de IA para que se tornem colaboradores mais confiáveis.”

IA centrada no ser humano

“A linguagem foi um choque cultural para mim quando cheguei aos EUA como estudante internacional”, disse Yang. “Rapidamente ficou claro que não se trata apenas de palavras e gramática. A linguagem reflete tanto a cultura quanto as pessoas que a moldam.”

Essa experiência motivou Yang a estudar como os sistemas de IA processam diferentes idiomas e como pessoas de diferentes culturas vivenciam esses sistemas.

Os modelos de IA são treinados desproporcionalmente com dados em inglês, portanto, os sistemas de IA geralmente funcionam melhor para pessoas que leem e falam inglês. Mesmo dentro do idioma inglês, existem disparidades em como os dados linguísticos são processados pela IA. A pesquisa de Yang descobriu que pessoas que vivem em diferentes partes dos EUA (e do mundo), com suas próprias variedades do inglês, têm experiências diferentes com sistemas de IA.

“Nosso laboratório está trabalhando para tornar os modelos de IA mais inclusivos, para que possam entender mais idiomas em geral, e esperamos construir sistemas de IA que entendam os diferentes idiomas regionais, para que pessoas em, por exemplo, Nova York, São Francisco e Atlanta possam vivenciar a tecnologia da mesma forma e ter uma experiência positiva com a IA”, disse Yang.

O interesse de Yang em IA centrada no ser humano se estende à criação e teste de ferramentas, como grandes modelos de linguagem projetados para ajudar as pessoas a aprimorarem suas habilidades sociais.

“Habilidades sociais são realmente muito difíceis de aprender”, disse Yang. “Isso me levou a perguntar: existe uma maneira de usarmos IA para ensinar habilidades sociais?”

Em resposta, Yang e seu laboratório criaram uma estrutura de IA, chamada Parceiro de IA e Mentor de IA , que permite aos usuários simular conversas com um Parceiro de IA e receber orientação de um Mentor de IA. Usando essa estrutura, o laboratório de Yang está desenvolvendo o Ensaio, para ajudar os usuários a praticarem a resolução de conflitos, e o CARE, para ajudar os terapeutas a praticarem o apoio emocional aos pacientes.

“A capacidade de ensaiar uma conversa em potencial e receber feedback personalizado é importante porque a maioria das pessoas não tem os recursos ou o capital social para aprender essas habilidades interpessoais”, disse Yang. “Descobrimos que apenas 20 minutos de prática com o Parceiro de IA e o Mentor de IA podem ajudar as pessoas a desenvolverem habilidades sociais e a se tornarem mais conscientes de como usar linguagem empática e perguntas abertas.”

Avançando com responsabilidade

Antecipar como os sistemas de IA provavelmente evoluirão e serão usados no futuro é fundamental para a segurança, confiabilidade e impacto social da IA, explicaram os pesquisadores.

“Nos últimos anos, a pesquisa em IA se concentrou na criação de chatbots como o ChatGPT e o Claude”, disse Schmidt. “Em seguida, os pesquisadores irão além dos modelos de IA que respondem a perguntas, criando agentes de IA capazes de realizar tarefas complexas de forma autônoma. Isso provavelmente exigirá novos dados de treinamento especializados, e estou animado para descobrir como construir esses conjuntos de dados.”

Yang também se mostra otimista em relação ao futuro da IA, mas ressalta os riscos associados ao uso descuidado dessa tecnologia. Compreender como e quando a IA pode falhar é vital, pois ajuda os pesquisadores a evitar armadilhas e a projetar algo positivo com essa tecnologia.

“Produtos e aplicações de IA podem entrar no mundo real muito rapidamente, muitas vezes sem uma compreensão rigorosa e cuidadosa de seu impacto ou das consequências de seu uso”, disse Yang. “Isso significa que, além dos avanços e das promessas da IA, também enfrentamos riscos e preocupações potenciais em seu uso. É por isso que precisamos avançar com responsabilidade.”