Tecnologia Científica

O aprendizado guiado permite que redes neurais 'intreináveis' realizem seu potencial

Pesquisadores do CSAIL descobriram que até mesmo redes neurais 'intreináveis' podem aprender efetivamente quando guiadas pelos vieses inerentes a outra rede, utilizando o método de orientação dela.

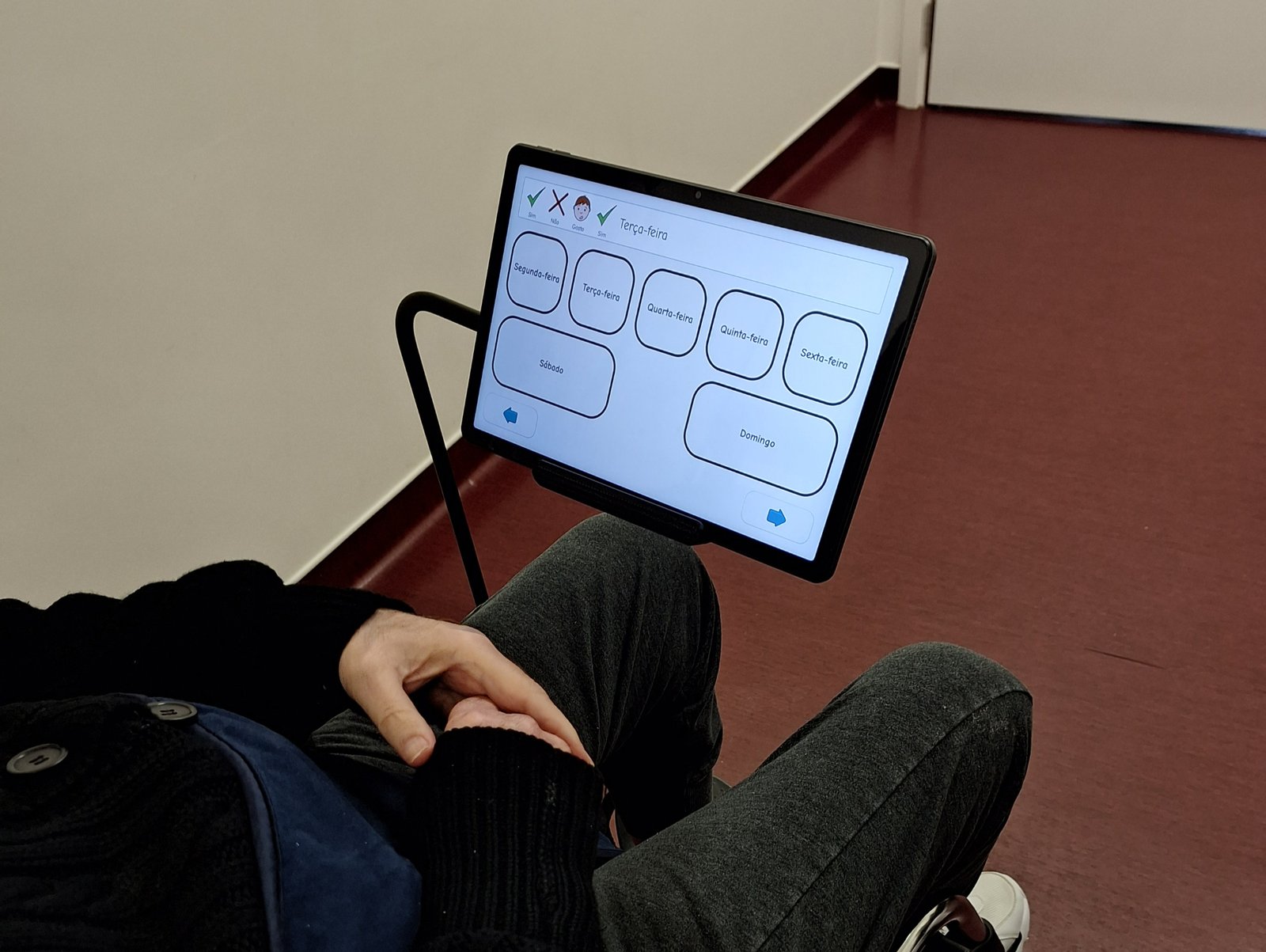

Pesquisadores do MIT descobriram que muitas redes consideradas "ineficazes" podem simplesmente partir de pontos de partida inadequados e que orientações de curto prazo podem fortalecer seu desempenho. Créditos: Imagem: Alex Shipps/MIT CSAIL

Até mesmo redes consideradas "incapazes de aprender" podem aprender de forma eficaz com um pouco de ajuda. Pesquisadores do Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL) do MIT demonstraram que um breve período de alinhamento entre redes neurais, um método que denominam orientação, pode melhorar drasticamente o desempenho de arquiteturas anteriormente consideradas inadequadas para tarefas modernas.

Suas descobertas sugerem que muitas das chamadas redes "ineficazes" podem simplesmente começar de pontos de partida menos que ideais, e que a orientação de curto prazo pode colocá-las em uma posição que facilite o aprendizado para a rede.

O método de orientação da equipe funciona incentivando uma rede alvo a corresponder às representações internas de uma rede guia durante o treinamento. Ao contrário de métodos tradicionais, como a destilação de conhecimento, que se concentram em imitar as saídas de um professor, a orientação transfere conhecimento estrutural diretamente de uma rede para outra. Isso significa que a rede alvo aprende como a rede guia organiza as informações em cada camada, em vez de simplesmente copiar seu comportamento. Notavelmente, mesmo redes não treinadas contêm vieses arquitetônicos que podem ser transferidos, enquanto as redes guia treinadas transmitem, adicionalmente, padrões aprendidos.

“Achamos esses resultados bastante surpreendentes”, diz Vighnesh Subramaniam '23, MEng '24, estudante de doutorado do Departamento de Engenharia Elétrica e Ciência da Computação (EECS) do MIT e pesquisador do CSAIL, autor principal de um artigo que apresenta essas descobertas. “É impressionante que tenhamos conseguido usar a similaridade representacional para fazer com que essas redes tradicionalmente consideradas 'ruins' realmente funcionem.”

Anjo guia-iano

Uma questão central era se a orientação precisa continuar durante todo o treinamento ou se seu principal efeito é proporcionar uma melhor inicialização. Para explorar isso, os pesquisadores realizaram um experimento com redes neurais profundas totalmente conectadas (FCNs). Antes do treinamento com o problema real, a rede passou alguns passos praticando com outra rede usando ruído aleatório, como um alongamento antes do exercício. Os resultados foram surpreendentes: redes que normalmente sofriam de sobreajuste permaneceram estáveis imediatamente, alcançaram menor perda de treinamento e evitaram a clássica degradação de desempenho observada em algo chamado FCNs padrão. Esse alinhamento atuou como um aquecimento útil para a rede, mostrando que mesmo uma breve sessão de prática pode ter benefícios duradouros sem a necessidade de orientação constante.

O estudo também comparou a orientação com a destilação de conhecimento, uma abordagem popular na qual uma rede do aluno tenta imitar as saídas de um professor. Quando a rede do professor não era treinada, a destilação falhou completamente, já que as saídas não continham nenhum sinal significativo. A orientação, por outro lado, ainda produziu melhorias significativas porque aproveita representações internas em vez de previsões finais. Esse resultado destaca uma descoberta fundamental: redes não treinadas já codificam vieses arquitetônicos valiosos que podem direcionar outras redes para um aprendizado eficaz.

Além dos resultados experimentais, as descobertas têm amplas implicações para a compreensão da arquitetura de redes neurais. Os pesquisadores sugerem que o sucesso — ou o fracasso — muitas vezes depende menos de dados específicos da tarefa e mais da posição da rede no espaço de parâmetros. Ao alinhar-se com uma rede guia, é possível separar as contribuições dos vieses arquitetônicos daquelas do conhecimento adquirido. Isso permite que os cientistas identifiquem quais características do projeto de uma rede favorecem o aprendizado eficaz e quais desafios decorrem simplesmente de uma inicialização inadequada.

A orientação também abre novas avenidas para o estudo das relações entre arquiteturas. Ao medir a facilidade com que uma rede pode guiar outra, os pesquisadores podem investigar as distâncias entre projetos funcionais e reexaminar teorias de otimização de redes neurais. Como o método se baseia na similaridade representacional, ele pode revelar estruturas anteriormente ocultas no projeto da rede, ajudando a identificar quais componentes contribuem mais para o aprendizado e quais não contribuem.

Resgatando os desesperados

Em última análise, o trabalho demonstra que as chamadas redes "intreináveis" não estão inerentemente fadadas ao fracasso. Com orientação, os modos de falha podem ser eliminados, o sobreajuste evitado e arquiteturas anteriormente ineficazes alinhadas aos padrões de desempenho modernos. A equipe do CSAIL planeja explorar quais elementos arquitetônicos são os principais responsáveis por essas melhorias e como esses insights podem influenciar o design futuro de redes. Ao revelar o potencial oculto até mesmo das redes mais resistentes, a orientação fornece uma nova e poderosa ferramenta para compreender — e, com sorte, moldar — os fundamentos do aprendizado de máquina.

“Geralmente se assume que diferentes arquiteturas de redes neurais têm pontos fortes e fracos específicos”, diz Leyla Isik, professora assistente de ciência cognitiva da Universidade Johns Hopkins, que não participou da pesquisa. “Esta pesquisa empolgante mostra que um tipo de rede pode herdar as vantagens de outra arquitetura, sem perder suas capacidades originais. Notavelmente, os autores mostram que isso pode ser feito usando pequenas redes 'guia' não treinadas. Este artigo apresenta uma maneira inovadora e concreta de adicionar diferentes vieses indutivos às redes neurais, o que é fundamental para o desenvolvimento de IA mais eficiente e alinhada ao comportamento humano.”

Subramaniam escreveu o artigo com colegas do CSAIL: o cientista pesquisador Brian Cheung; o estudante de doutorado David Mayo (turma de 2018) e mestre em engenharia (turma de 2019); o pesquisador associado Colin Conwell; os investigadores principais Boris Katz, cientista pesquisador principal do CSAIL, e Tomaso Poggio, professor do MIT em ciências cerebrais e cognitivas; e o ex-cientista pesquisador do CSAIL, Andrei Barbu. O trabalho foi financiado, em parte, pelo Centro para Cérebros, Mentes e Máquinas, pela Fundação Nacional de Ciência (NSF), pela Iniciativa de Aplicações de Aprendizado de Máquina do MIT CSAIL, pelo Laboratório de IA Watson MIT-IBM, pela Agência de Projetos de Pesquisa Avançada de Defesa dos EUA (DARPA), pelo Acelerador de Inteligência Artificial do Departamento da Força Aérea dos EUA e pelo Escritório de Pesquisa Científica da Força Aérea dos EUA.

O trabalho foi apresentado recentemente na Conferência e Workshop sobre Sistemas de Processamento de Informação Neural (NeurIPS).