Tecnologia Científica

Repensando — e reformulando — a superinteligência

Pesquisador da Microsoft afirma que separar a IA das pessoas torna os sistemas perigosos e improdutivos.

E. Glen Weyl. Stephanie Mitchell/Fotógrafa da Equipe de Harvard

O debate sobre a superinteligência artificial (ASI) tende a extremos, com previsões de que ela salvará ou destruirá a humanidade. E. Glen Weyl tem uma perspectiva diferente: a superinteligência já existe, e há milhares de anos.

Em uma palestra realizada em 19 de novembro no Berkman Klein Center, Weyl, economista da Microsoft Research e coautor do livro "Mercados Radicais", incentivou os ouvintes a pensarem sobre a superinteligência no contexto da "Hipótese de Gaia" de James Lovelock, ou seja, como um sistema coletivo autorregulado que abrange todos os seres vivos e o meio ambiente natural.

Essa visão, disse ele, contrasta com as representações comuns da IA como uma máquina que ingere informações e as processa e age de forma autônoma — com o objetivo final de igualar ou superar as capacidades humanas. Essa perspectiva é mais do que filosófica, argumentou ele. Ela muda a forma como os engenheiros constroem sistemas de IA — e não para melhor.

“Quando separamos os sistemas digitais das pessoas, tornamo-los perigosos porque não possuem o feedback necessário para manter a homeostase, e também não são úteis porque não estão integrados aos processos de produção e à participação humana.”

Na verdade, disse Weyl, “A superinteligência já está por toda parte: corporações, democracias, religiões, culturas — todas essas coisas manifestam capacidades que os humanos não possuem por si só. Pensamos na superinteligência artificial como algo único. Em vez disso, estou sugerindo que ela é outra maneira que nos permite mapear as relações sociais humanas e, assim, expandi-las.”

Segundo Weyl, os sistemas religiosos, governamentais e corporativos demonstram superinteligência porque se baseiam em uma autoconsciência coletiva para ampliar as capacidades humanas de maneiras que permitem que grandes comunidades alcancem seus objetivos. Eles também fortalecem a coesão além do que os humanos poderiam fazer individualmente ou em grupo.

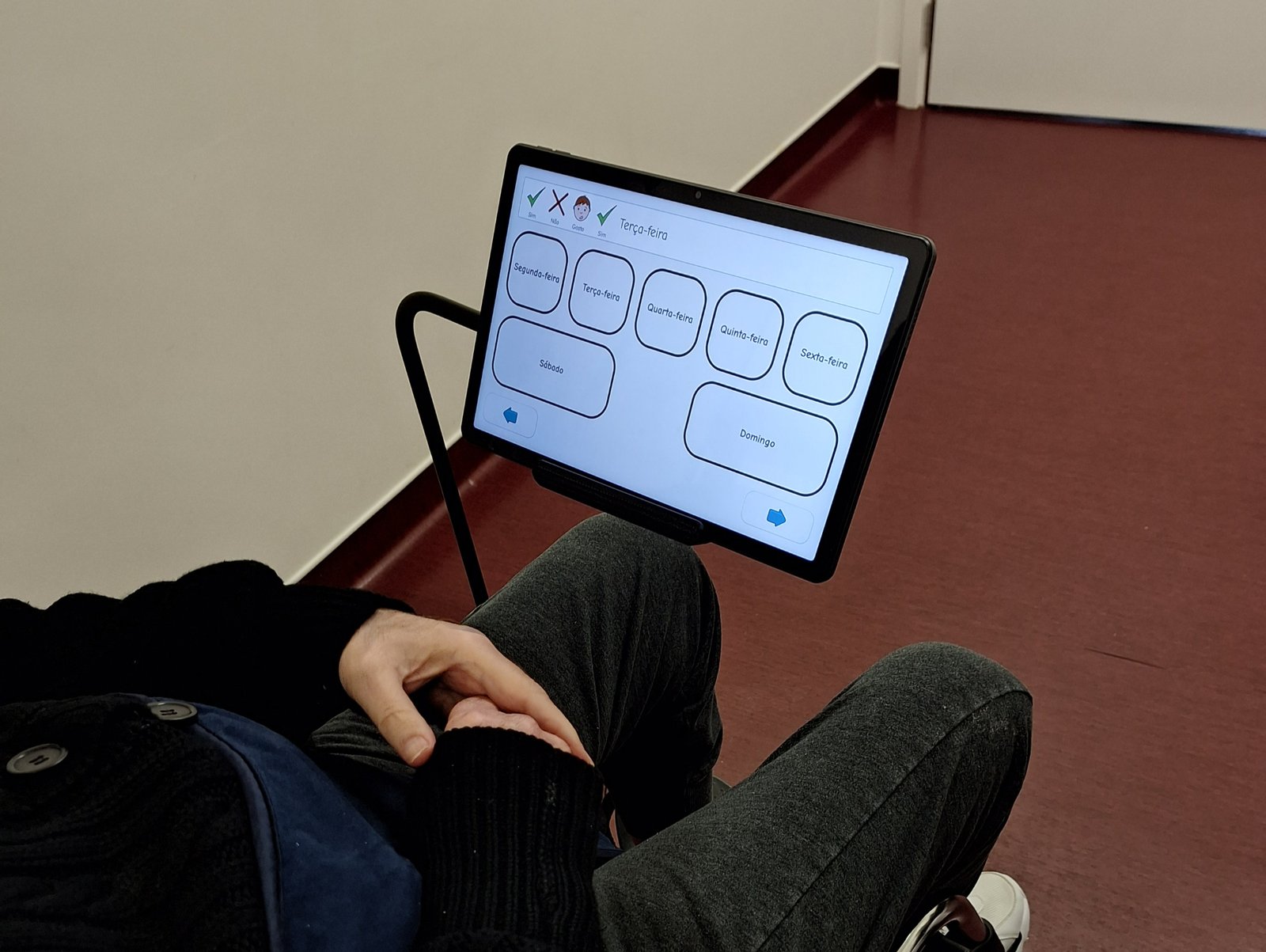

Weyl citou o sistema Kaizen japonês, implementado após a Segunda Guerra Mundial, como um exemplo. Quando os operários recebiam informações cuidadosamente direcionadas sobre o processo de produção em geral e seus papéis dentro dele, eles se tornavam mais capazes de inovar e aprimorar as operações em cada etapa individual. "Você não pode instruir todos os operários da linha de produção sobre tudo o que envolve a fabricação de um carro", explicou Weyl, "então você precisa apostar em qual é a informação mais importante e relevante."

O conceito central de superinteligência de Weyl reside na ideia de conhecimento comum — informação que, nas palavras de Weyl, “não apenas eu sei e você sabe, mas eu sei que você sabe, e eu sei que você sabe que eu sei — e assim por diante”. Ele ofereceu “A Roupa Nova do Imperador” como exemplo; cada indivíduo sabe que o imperador está nu, mas somente quando uma criança ri em público é que todos percebem que estão vendo a mesma coisa.

As redes sociais e as concepções modernas de superinteligência minam esse conhecimento compartilhado, argumentou Weyl. Na China, disse ele, a censura governamental dos espaços online dificulta a união das comunidades em torno de um conhecimento comum. Nas culturas ocidentais, as redes sociais exacerbaram a polarização ao privilegiar vozes divisivas.

Alguns países, no entanto, adotaram uma abordagem humanista para diminuir a polarização e aumentar a compreensão. Ele citou ferramentas criadas pelo governo taiwanês para ajudar a amenizar as divisões, incluindo o Polis , que mostra aos usuários como as postagens nas redes sociais se encaixam em diferentes grupos ideológicos e detalha as semelhanças entre ideias aparentemente díspares. "Isso é uma espécie de vacina, ou cura, para um ataque de polarização", disse Weyl.

Em uma discussão após a palestra com Moira Weigel, professora assistente de literatura comparada e associada do corpo docente do Berkman Klein, Weyl explicou como define inteligência para sistemas tecnológicos. Segundo ele, é mais importante que os sistemas monitorem seu próprio funcionamento e respondam às informações recebidas com uma lógica interna do que simplesmente concluir uma tarefa de maneira semelhante à humana.

Ao refletir sobre se o Oriente ou o Ocidente "venceriam" a batalha da IA, Weyl rejeitou essa perspectiva por considerá-la irrelevante. "Se você está numa corrida para se chocar contra uma parede, quem vence é quem desvia no final, e não quem bate na parede", afirmou.

No final das contas, disse Weyl, o importante não é a força do sistema, mas sim como ele se adapta.