Tecnologia Científica

Mostrando aos robôs como executar suas tarefas

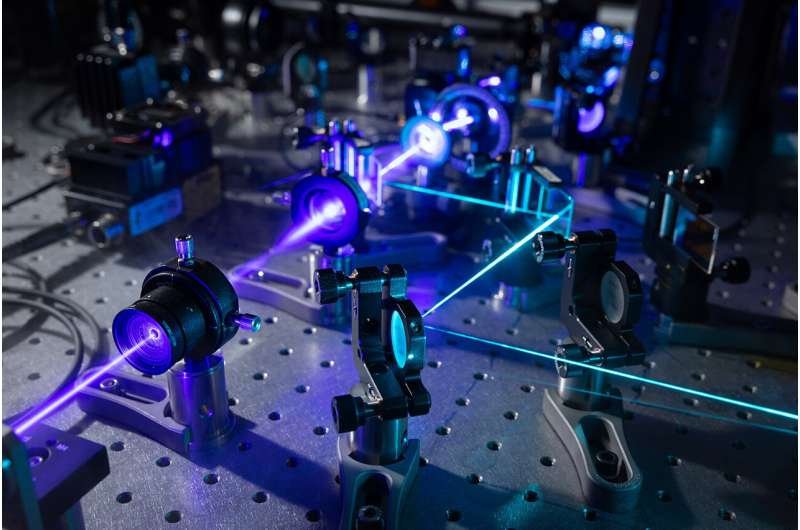

Observando humanos, os robôs aprendem a executar tarefas complexas, como arrumar uma mesa.

Imagem: Christine Daniloff, MITÂ Â

Os roboticistas estãodesenvolvendo robôs automatizados que podem aprender novas

tarefas apenas observando seres humanos. Em casa, um dia vocêpode mostrar a um

roba´ domanãstico como fazer tarefas rotineiras.

O treinamento de robôs interativos pode um dia ser um trabalho fa¡cil para todos, mesmo para quem não tem experiência em programação. Os roboticistas estãodesenvolvendo robôs automatizados que podem aprender novas tarefas apenas observando seres humanos. Em casa, um dia vocêpode mostrar a um roba´ domanãstico como fazer tarefas rotineiras. No local de trabalho, vocêpode treinar robôs como novos funciona¡rios, mostrando a eles como executar muitas tarefas.

Progredindo nessa visão, os pesquisadores do MIT projetaram um sistema que permite que esses tipos de robôs aprendam tarefas complicadas que, de outra forma, os frustrariam com muitas regras confusas. Uma dessas tarefas écolocar uma mesa de jantar sob certas condições. Â

Em sua essaªncia, o sistema “Planejamento com especificações incertas†(PUnS) dos pesquisadores oferece aos robôs a capacidade de planejamento semelhante a humanos para pesar simultaneamente muitos requisitos ambaguos - e potencialmente contradita³rios - para alcana§ar um objetivo final. Ao fazer isso, o sistema sempre escolhe a ação mais prova¡vel a ser tomada, com base em uma "crena§a" sobre algumas especificações prova¡veis ​​para a tarefa que ele deve executar.

Em seu trabalho, os pesquisadores compilaram um conjunto de dados com informações sobre como oito objetos - uma caneca, copo, colher, garfo, faca, prato de jantar, prato pequeno e tigela - poderiam ser colocados sobre uma mesa em várias configurações. Um braa§o roba³tico primeiro observou demonstrações humanas selecionadas aleatoriamente de arrumar a mesa com os objetos. Em seguida, os pesquisadores encarregaram o braa§o de definir automaticamente uma tabela em uma configuração especafica, em experimentos do mundo real e em simulação, com base no que havia visto.

Para ter sucesso, o roba´ teve que pesar muitas ordens de posicionamento possaveis, mesmo quando os itens foram removidos, empilhados ou ocultos propositadamente. Normalmente, tudo isso confundiria muito os robôs. Mas o roba´ dos pesquisadores não cometeu erros ao longo de várias experiências no mundo real, e apenas alguns erros ao longo de dezenas de milhares de testes simulados. Â

"A visão écolocar a programação nas ma£os de especialistas em domanio, que podem programar robôs de maneira intuitiva, em vez de descrever ordens para um engenheiro adicionar ao seu ca³digo", diz o primeiro autor Ankit Shah, estudante de graduação do Departamento de Aerona¡utica e Astronautics (AeroAstro) e o Interactive Robotics Group, que enfatiza que o trabalho deles éapenas um passo na realização dessa visão. Dessa forma, os robôs não precisara£o mais executar tarefas pré-programadas. Trabalhadores de fa¡brica podem ensinar um roba´ a executar várias tarefas complexas de montagem. Os robôs domanãsticos podem aprender a empilhar arma¡rios, carregar a ma¡quina de lavar loua§a ou arrumar a mesa das pessoas em casa. â€

Juntando-se a Shah, estãoa estudante de graduação AeroAstro e Interactive Robotics Group, Shen Li, e a lider do grupo Interactive Robotics Julie Shah, professora associada no AeroAstro e no Laborata³rio de Ciência da Computação e Inteligaªncia Artificial.

Apostas de cobertura de robôs

Os robôs são bons planejadores em tarefas com “especificações†claras, que ajudam a descrever a tarefa que o roba´ precisa realizar, considerando suas ações, ambiente e objetivo final. Aprender a arrumar uma mesa observando demonstrações estãocheio de especificações incertas. Os itens devem ser colocados em determinados locais, dependendo do menu e onde os convidados estãosentados, e em certos pedidos, dependendo da disponibilidade imediata de um item ou das convenções sociais. As atuais abordagens de planejamento não são capazes de lidar com essas especificações incertas.

Uma abordagem popular ao planejamento éo "aprendizado por reforço", uma técnica de aprendizado por ma¡quina de tentativa e erro que os recompensa e penaliza por ações enquanto trabalham para concluir uma tarefa. Mas para tarefas com especificações incertas, édifacil definir recompensas e penalidades claras. Em resumo, os robôs nunca aprendem totalmente o certo do errado.

O sistema dos pesquisadores, chamado PUnS (para o planejamento com especificações incertas), permite que um roba´ mantenha uma "crena§a" em várias especificações possaveis. A própria crena§a pode então ser usada para distribuir recompensas e penalidades. “O roba´ estãobasicamente fazendo hedge de suas apostas em termos do objetivo de uma tarefa e executa ações que satisfazem sua crena§a, em vez de fornecer uma especificação claraâ€, diz Ankit Shah.

O sistema éconstruado sobre “la³gica temporal linear†(LTL), uma linguagem expressiva que permite raciocanio roba³tico sobre resultados atuais e futuros. Os pesquisadores definiram modelos no LTL que modelam várias condições baseadas no tempo, como o que deve acontecer agora, devem eventualmente acontecer e devem ocorrer atéque algo mais ocorra. As observações do roba´ de 30 demonstrações humanas para definir a tabela produziram uma distribuição de probabilidade em 25 fa³rmulas LTL diferentes. Cada fa³rmula codificava uma preferaªncia ligeiramente diferente - ou especificação - para definir a tabela. Essa distribuição de probabilidade se torna sua crena§a.

“Cada fa³rmula codifica algo diferente, mas quando o roba´ considera várias combinações de todos os modelos e tenta satisfazer tudo junto, acaba fazendo a coisa certa eventualmenteâ€, diz Ankit Shah.

Seguintes critanãrios

Os pesquisadores também desenvolveram vários critanãrios que orientam o roba´ a satisfazer toda a crena§a sobre as fa³rmulas candidatas. Uma, por exemplo, satisfaz a fa³rmula mais prova¡vel, que descarta todo o resto, exceto o modelo, com a maior probabilidade. Outros satisfazem o maior número de fa³rmulas exclusivas, sem considerar sua probabilidade geral, ou satisfazem várias fa³rmulas que representam a probabilidade total mais alta. Outro simplesmente minimiza o erro, de modo que o sistema ignora fa³rmulas com alta probabilidade de falha.

Os designers podem escolher qualquer um dos quatro critanãrios a serem predefinidos antes do treinamento e dos testes. Cada um tem sua própria troca entre flexibilidade e aversão ao risco. A escolha dos critanãrios depende inteiramente da tarefa. Em situações craticas de segurança, por exemplo, um projetista pode optar por limitar a possibilidade de falha. Mas onde as consequaªncias do fracasso não são tão graves, os designers podem optar por dar aos robôs maior flexibilidade para tentar abordagens diferentes.

Com os critanãrios estabelecidos, os pesquisadores desenvolveram um algoritmo para converter a crena§a do roba´ - a distribuição de probabilidade apontando para a fa³rmula desejada - em um problema equivalente de aprendizado por reforço. Este modelo fara¡ ping no roba´ com uma recompensa ou penalidade por uma ação que seja executada, com base nas especificações que ele decidiu seguir.

Em simulações pedindo ao roba´ para pa´r a mesa em diferentes configurações, ele cometeu apenas seis erros em 20.000 tentativas. Nas demonstrações do mundo real, mostrava comportamento semelhante ao desempenho de um humano. Se um item não estivesse inicialmente visível, por exemplo, o roba´ terminaria de definir o restante da tabela sem o item. Então, quando o garfo era revelado, ele colocava o garfo no lugar apropriado. "a‰ aa que a flexibilidade émuito importante", diz Ankit Shah. "Caso contra¡rio, ele ficara¡ preso quando espera colocar um garfo e não concluir o restante da configuração da mesa."

Em seguida, os pesquisadores esperam modificar o sistema para ajudar os robôs a mudar seu comportamento com base em instruções verbais, correções ou avaliação de um usua¡rio sobre o desempenho do roba´. “Digamos que uma pessoa demonstre a um roba´ como colocar uma mesa em um aºnico local. A pessoa pode dizer: 'faz a mesma coisa para todos os outros pontos' ou 'coloque a faca antes do garfo aqui' 'â€, diz Ankit Shah. "Queremos desenvolver manãtodos para o sistema se adaptar naturalmente a lidar com esses comandos verbais, sem a necessidade de demonstrações adicionais".

.jpg)