Tecnologia Científica

FoolChecker: Uma plataforma para verificar o quanto robusta éuma imagem contra ataques adversa¡rios

Essa nova plataforma, chamada FoolChecker, foi apresentada em um artigo publicado na revista Neurocomputing da Elsevier .

Crédito: Markus Spiske, Unsplash

Atéagora, as redes neurais profundas (DNNs) provaram ser altamente promissoras para uma ampla gama de aplicações, incluindo classificação de imagem e a¡udio. No entanto, seu desempenho depende muito da quantidade de dados usada para treina¡-los, e grandes conjuntos de dados nem sempre estãodisponaveis.

Quando os DNNs não são treinados adequadamente, eles são mais propensos a classificar dados incorretamente. Isso os torna vulnera¡veis ​​a uma classe especafica de ataques cibernanãticos, conhecidos como ataques adversa¡rios . Em um ataque adversa¡rio, um invasor cria ranãplicas de dados reais projetados para enganar um DNN (ou seja, dados adversa¡rios), enganando-o para classificar dados incorretamente e, assim, prejudicar sua função.

Nos últimos anos, cientistas e desenvolvedores de computadores propuseram uma variedade de ferramentas que poderiam proteger arquiteturas neurais profundas desses ataques, detectando as diferenças entre os dados originais e os adversa¡rios. No entanto, atéagora, nenhuma dessas soluções se mostrou universalmente eficaz.

"Primeiro, a evolução diferencial éaplicada para gerar unidades de perturbação candidatas com alta prioridade de perturbação", escreveram os pesquisadores. "Então, o algoritmo ganancioso tenta adicionar o pixel com a maior prioridade de perturbação atual nas unidades de perturbação atéque o modelo DNN seja enganado. Finalmente, a distância perceptiva das unidades de perturbação écalculada como um andice para avaliar a robustez das imagens contra ataques adversos. "

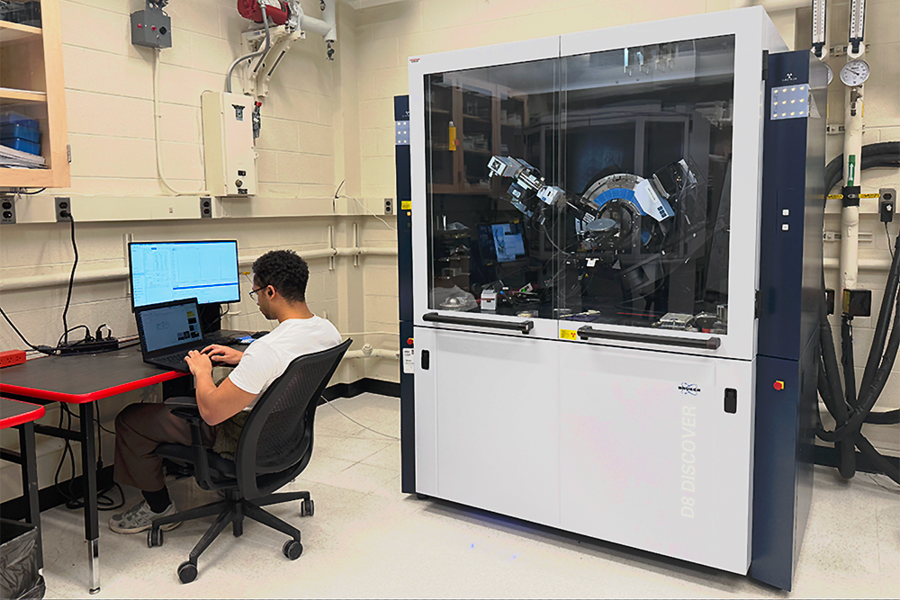

Pesquisadores da Universidade de Wuhan e da Escola Profissional de Engenharia e Software de Wuhan introduziram recentemente uma plataforma que pode avaliar a robustez das imagens a ataques adversa¡rios, calculando a facilidade com que eles são replicados de uma maneira que enganaria um DNN. Essa nova plataforma, chamada FoolChecker, foi apresentada em um artigo publicado na revista Neurocomputing da Elsevier .

"Nosso artigo apresenta uma plataforma chamada FoolChecker para avaliar a robustez da imagem contra ataques adversa¡rios da perspectiva da própria imagem, e não dos modelos DNN", escreveram os pesquisadores em seu artigo. "Definimos a distância perceptiva manima entre os exemplos originais e os adversa¡rios para quantificar a robustez contra ataques adversa¡rios".

O FoolChecker éum dos primeiros manãtodos para quantificar a robustez das imagens contra ataques adversa¡rios. Na simulação, essa técnica obteve resultados nota¡veis, completando seus ca¡lculos em um período de tempo relativamente curto.

Ao desenvolver sua plataforma, os pesquisadores compararam várias manãtricas para quantificar as distâncias entre imagens originais e imagens adversas. A manãtrica que se mostrou mais eficaz foi a distância de sensibilidade a perturbação (PSD) entre amostras originais e adversa¡rias.

O FoolChecker funciona calculando o PSD manimo necessa¡rio para enganar um classificador DNN com aªxito. Enquanto o ca¡lculo manual levaria muito tempo, os pesquisadores desenvolveram uma abordagem que combina uma técnica conhecida como evolução diferencial (DE) e um algoritmo ganancioso, uma arquitetura intuitiva que éfrequentemente usada para resolver problemas de otimização.

"Primeiro, a evolução diferencial éaplicada para gerar unidades de perturbação candidatas com alta prioridade de perturbação", escreveram os pesquisadores. "Então, o algoritmo ganancioso tenta adicionar o pixel com a maior prioridade de perturbação atual nas unidades de perturbação atéque o modelo DNN seja enganado. Finalmente, a distância perceptiva das unidades de perturbação écalculada como um andice para avaliar a robustez das imagens contra ataques adversos. "

Os pesquisadores avaliaram o FoolChecker em uma sanãrie de testes e descobriram que ele pode efetivamente calcular a robustez de uma determinada imagem para ataques adversos quando processada por vários DNNs. O estudo deles oferece evidaªncias de que a vulnerabilidade adversa de um modelo DNN também pode ser devida a fatores externos (ou seja, que não estãovinculados ao desempenho do modelo), como os recursos das imagens que ele estãoprocessando.

Em outras palavras, a equipe descobriu que as próprias imagens podem variar em termos da extensão em que são fa¡ceis de modificar, de maneira a induzir DNNs a classificar dados incorretamente. No futuro, a plataforma que eles desenvolveram podera¡ ser usada para avaliar a robustez dos dados fornecidos a s DNNs, o que pode impedir que os invasores criem dados adversa¡rios e, assim, realizem seus ataques.