Tecnologia Científica

Algoritmo ajuda os sistemas de inteligaªncia artificial a evitar entradas 'adversa¡rias'

O manãtodo baseia-se em técnicas de jogo para ajudar os veaculos auta´nomos a navegar no mundo real, onde os sinais podem ser imperfeitos.

Um algoritmo de aprendizado profundo desenvolvido por pesquisadores do MIT éprojetado para ajudar as ma¡quinas a navegar no mundo real. Em testes com o videogame Pong, os pesquisadores introduziram um “adversa¡rio†que puxou a bola um pouco mais para baixo do que realmente estava. Créditos: Imagem: Jose-Luis Olivares, MIT

Em um mundo perfeito, o que vocêvaª éo que vocêobtanãm. Se fosse esse o caso, o trabalho dos sistemas de inteligaªncia artificial seria renovadoramente simples.

Considere os sistemas anticolisão em carros auta´nomos. Se a entrada visual das ca¢meras a bordo pudesse ser totalmente confia¡vel, um sistema de IA poderia mapear diretamente essa entrada para uma ação apropriada - vire a direita, vire a esquerda ou continue em frente - para evitar atingir um pedestre que suas ca¢meras veem na estrada.

Mas e se houver uma falha nas ca¢meras que desloca levemente uma imagem em alguns pixels? Se o carro confiasse cegamente nas chamadas “contribuições adversa¡riasâ€, ele poderia tomar medidas desnecessa¡rias e potencialmente perigosas.

Um novo algoritmo de aprendizagem profunda desenvolvido por pesquisadores do MIT éprojetado para ajudar as ma¡quinas a navegar no mundo real e imperfeito, criando um “ceticismo†sauda¡vel em relação a s medições e informações que recebem.

A equipe combinou um algoritmo de aprendizado por reforço com uma rede neural profunda, ambos usados ​​separadamente para treinar computadores em jogos de videogame como Go e xadrez, para construir uma abordagem que eles chamam de CARRL, para Certified Adversarial Robustness for Deep Reinforcement Learning.

Os pesquisadores testaram a abordagem em vários cenários, incluindo um teste simulado de prevenção de colisão e o videogame Pong, e descobriram que o CARRL teve um desempenho melhor - evitando colisaµes e ganhando mais jogos Pong - do que as técnicas de aprendizado de ma¡quina padra£o, mesmo em face de incertezas , entradas adversa¡rias.

“Muitas vezes vocêpensa que um adversa¡rio éalguém que estãohackeando seu computador, mas também pode ser apenas que seus sensores não são bons ou suas medições não são perfeitas, o que costuma ser o casoâ€, diz Michael Everett, pa³s-doutorado no MIT's Departamento de Aerona¡utica e Astrona¡utica (AeroAstro). “Nossa abordagem ajuda a contabilizar essa imperfeição e tomar uma decisão segura. Em qualquer domanio crítico de segurança, esta éuma abordagem importante para se pensar. â€

Everett éo autor principal de um estudo que descreve a nova abordagem, que aparece no IEEE's Transactions on Neural Networks and Learning Systems . O estudo se originou da tese de mestrado do aluno de doutorado do MIT Bja¶rn La¼tjens e foi orientado pelo professor Jonathan How do MIT AeroAstro.

Realidades possaveis

Para tornar os sistemas de IA robustos contra entradas adversa¡rias, os pesquisadores tentaram implementar defesas para aprendizagem supervisionada. Tradicionalmente, uma rede neural étreinada para associar ra³tulos ou ações especaficas a determinadas entradas. Por exemplo, uma rede neural que éalimentada por milhares de imagens rotuladas como gatos, junto com imagens rotuladas como casas e cachorros-quentes, deve rotular corretamente uma nova imagem como um gato.

Em sistemas robustos de IA, as mesmas técnicas de aprendizado supervisionado podem ser testadas com muitas versaµes ligeiramente alteradas da imagem. Se a rede cair no mesmo ra³tulo - gato - para cada imagem, háuma boa chance de que, alterada ou não, a imagem seja realmente de um gato, e a rede seja robusta a qualquer influaªncia adversa¡ria.

Mas executar todas as alterações de imagem possaveis écomputacionalmente exaustivo e difacil de aplicar com sucesso a tarefas urgentes, como evitar colisaµes. Além disso, os manãtodos existentes também não identificam qual ra³tulo usar, ou que ação tomar, se a rede for menos robusta e rotular algumas imagens de gato alteradas como uma casa ou cachorro-quente.

“Para usar redes neurais em cenários craticos para a segurança, tivemos que descobrir como tomar decisaµes em tempo real com base nas suposições do pior caso sobre essas possaveis realidadesâ€, diz La¼tjens.

A melhor recompensa

Em vez disso, a equipe procurou construir o aprendizado por reforço, outra forma de aprendizado de ma¡quina que não exige a associação de entradas rotuladas com saadas, mas visa reforçar certas ações em resposta a certas entradas, com base em uma recompensa resultante. Essa abordagem énormalmente usada para treinar computadores para jogar e ganhar jogos como xadrez e Go.

A aprendizagem por reforço tem sido aplicada principalmente a situações em que as entradas são consideradas verdadeiras. Everett e seus colegas dizem que são os primeiros a trazer “robustez certifica¡vel†para dados incertos e adversa¡rios na aprendizagem por reforço.

Sua abordagem, CARRL, usa um algoritmo de aprendizado de reforço profundo existente para treinar uma rede Q profunda, ou DQN - uma rede neural com várias camadas que, em última análise, associa uma entrada a um valor Q ounívelde recompensa.

A abordagem usa uma entrada, como uma imagem com um aºnico ponto, e considera uma influaªncia adversa¡ria ou uma regia£o ao redor do ponto onde ela realmente poderia estar. Cada posição possível do ponto dentro desta regia£o éalimentada por um DQN para encontrar uma ação associada que resultaria na melhor recompensa de pior caso, com base em uma técnica desenvolvida pela recente estudante graduada do MIT Tsui-Wei “Lily†Weng PhD ' 20

Um mundo adversa¡rio

Em testes com o videogame Pong, em que dois jogadores operam os remos em cada lado de uma tela para passar a bola para frente e para trás, os pesquisadores introduziram um “adversa¡rio†que puxou a bola um pouco mais para baixo do que realmente estava. Eles descobriram que o CARRL ganhava mais jogos do que as técnicas padra£o, a medida que a influaªncia do adversa¡rio aumentava.

“Se sabemos que não se deve confiar exatamente em uma medição e que a bola pode estar em qualquer lugar dentro de uma determinada regia£o, então nossa abordagem diz ao computador que ele deve colocar a raquete no meio dessa regia£o, para garantir que acertemos o bola mesmo no pior caso de desvio â€, diz Everett.

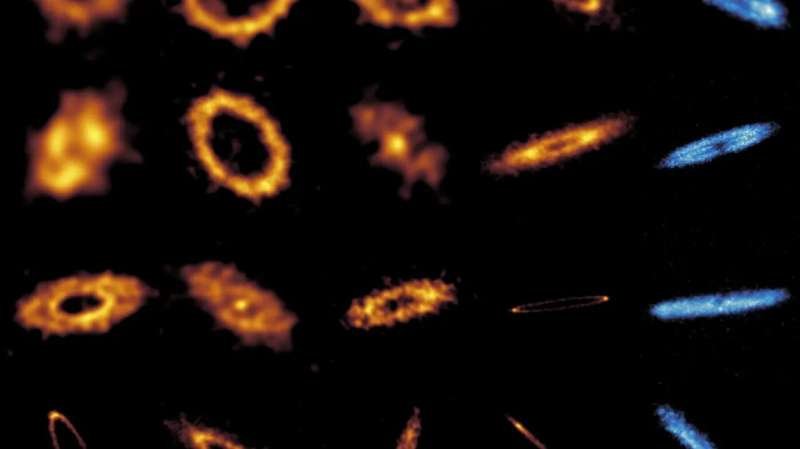

O manãtodo foi similarmente robusto em testes de prevenção de colisão, onde a equipe simulou um agente azul e um laranja tentando trocar de posição sem colidir. Enquanto a equipe perturbava a observação do agente laranja sobre a posição do agente azul, o CARRL conduziu o agente laranja ao redor do outro agente, afastando-se mais a medida que o adversa¡rio ficava mais forte e a posição do agente azul ficava mais incerta.

Chegou um ponto em que CARRL se tornou muito conservador, fazendo com que o agente laranja presumisse que o outro agente poderia estar em qualquer lugar em sua vizinhana§a e, em resposta, evitar completamente seu destino. Esse conservadorismo extremo éútil, diz Everett, porque os pesquisadores podem então usa¡-lo como um limite para ajustar a robustez do algoritmo. Por exemplo, o algoritmo pode considerar um desvio menor, ou regia£o de incerteza, que ainda permitiria a um agente obter uma alta recompensa e chegar ao seu destino.

Além de superar os sensores imperfeitos, Everett diz que o CARRL pode ser um começo para ajudar os robôs a lidar com interações imprevisaveis no mundo real com segurança.

“As pessoas podem ser adversa¡rias, como ficar na frente de um roba´ para bloquear seus sensores, ou interagir com eles, não necessariamente com as melhores intençõesâ€, diz Everett. “Como um roba´ pode pensar em todas as coisas que as pessoas podem tentar fazer e tentar evita¡-las? Contra que tipo de modelos adversa¡rios queremos nos defender? Isso éalgo que estamos pensando em como fazer. â€

Esta pesquisa foi apoiada, em parte, pela Ford Motor Company como parte da Ford-MIT Alliance.