Tecnologia Científica

Um modelo que pode criar animações realistas de rostos falantes

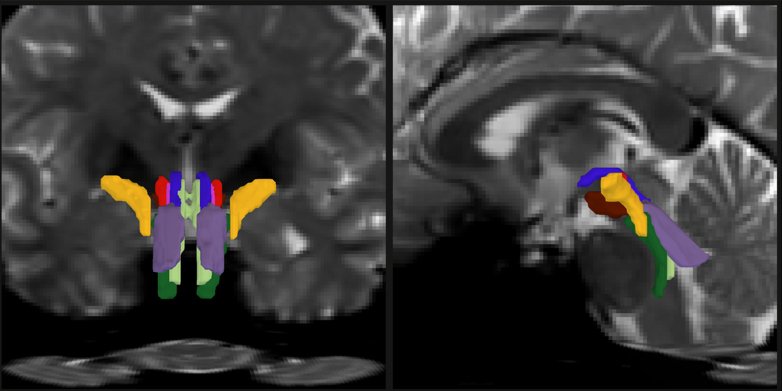

Produzir animaa§aµes convincentes do rosto de um personagem enquanto ele fala continua sendo um desafio fundamental, pois normalmente envolve a combinação bem-sucedida de uma sanãrie de diferentes elementos de a¡udio e vadeo.

Crédito: Biswas et al.

Nos últimos anos, as animações geradas por computador de animais e humanos tornaram-se cada vez mais detalhadas e realistas. No entanto, produzir animações convincentes do rosto de um personagem enquanto ele fala continua sendo um desafio fundamental, pois normalmente envolve a combinação bem-sucedida de uma sanãrie de diferentes elementos de a¡udio e vadeo.

Uma equipe de cientistas da computação da TCS Research na andia criou recentemente um novo modelo que pode produzir animações de rostos falantes altamente realistas que integram gravações de a¡udio com os movimentos da cabea§a de um personagem. Esse modelo, apresentado em um artigo apresentado no ICVGIP 2021, a danãcima segunda Conferência Indiana sobre Visão Computacional, Gra¡ficos e Processamento de Imagens, pode ser usado para criar avatares virtuais, assistentes digitais e filmes animados mais convincentes.

“Para uma experiência de visualização agrada¡vel, a percepção do realismo éde extrema importa¢ncia e, apesar dos recentes avanços da pesquisa, a geração de um rosto falante realista continua sendo um problema de pesquisa desafiadorâ€, disse Brojeshwar Bhowmick, um dos pesquisadores que realizaram o estudo. TechXplore. "Juntamente com a sincronização precisa dos la¡bios, a animação realista de rostos falantes requer outros atributos de realismo, como piscar de olhos naturais, movimentos da cabea§a e preservar informações de identidade de rostos de alvos arbitra¡rios".

A maioria dos manãtodos baseados em fala existentes para gerar animações de rosto se concentram em garantir uma boa sincronização entre os movimentos dos la¡bios e a fala gravada, preservando a identidade de um personagem e garantindo que ele pisque os olhos ocasionalmente. Alguns desses manãtodos também tentaram gerar movimentos de cabea§a convincentes, principalmente emulando aqueles realizados por falantes humanos em um pequeno vadeo de treinamento.

"Esses manãtodos derivam o movimento da cabea§a do vadeo de condução, que pode não estar correlacionado com o conteaºdo da fala atual e, portanto, parecer irreal para a animação de discursos longos", disse Bhowmick. "Em geral, o movimento da cabea§a depende em grande parte da informação prosãodica da fala em uma janela de tempo atual".

Estudos anteriores descobriram que háuma forte correlação entre os movimentos da cabea§a realizados por falantes humanos e o tom e a amplitude de sua voz. Essas descobertas inspiraram Bhowmick e seus colegas a criar um novo manãtodo que pode produzir movimentos de cabea§a para animações de rosto que refletem a voz de um personagem e o que ele estãodizendo.

Em um de seus trabalhos anteriores , os pesquisadores apresentaram uma arquitetura baseada em GAN (generative adversarial network) que poderia gerar animações convincentes de rostos conversando. Embora essa técnica fosse promissora, ela são conseguia produzir animações nas quais a cabea§a dos alto-falantes não se movia.

Â

“Desenvolvemos agora um pipeline completo de animação facial realista orientada por fala que gera vadeos de rostos falantes com sincronização labial precisa, piscadas naturais e movimento realista da cabea§a, criando uma abordagem hiera¡rquica para o aprendizado desembaraçado de movimento e texturaâ€, disse Bhowmick. "Aprendemos o movimento induzido pela fala em pontos de referaªncia faciais e usamos os pontos de referaªncia para gerar a textura dos quadros de vadeo de animação".

O novo modelo generativo criado por Bhowmick e seus colegas pode efetivamente gerar movimentos de cabea§a realistas e orientados pela fala para rostos falantes animados, que estãofortemente correlacionados com as caracteristicas vocais de um falante e o que ele estãodizendo. Assim como a técnica que eles criaram no passado, esse novo modelo ébaseado em GANs, uma classe de algoritmos de aprendizado de ma¡quina que se mostrou altamente promissora para gerar conteaºdo artificial.

O modelo pode identificar sobre o que um falante estãofalando e a entonação de sua voz durante janelas de tempo especaficas. Posteriormente, ele usa essas informações para produzir movimentos de cabea§a correspondentes e correlacionados.

"Nosso manãtodo éfundamentalmente diferente dos manãtodos de última geração que se concentram na geração de um estilo de fala especafico da pessoa a partir do vadeo de condução de amostra do sujeito-alvo", disse Bhowmick. "Dado que a relação entre o a¡udio e o movimento da cabea§a não éúnica, nosso mecanismo de atenção tenta aprender a importa¢ncia dos recursos de a¡udio local para o movimento local da cabea§a, mantendo a previsão suave ao longo do tempo, sem exigir nenhuma entrada de condução de vadeo no momento do teste. também use meta-aprendizagem para geração de textura, pois ajuda a se adaptar rapidamente a rostos desconhecidos usando muito poucas imagens no momento do teste."

Bhowmick e seus colegas avaliaram seu modelo em uma sanãrie de conjuntos de dados de referaªncia, comparando seu desempenho com o de técnicas de ponta desenvolvidas no passado. Eles descobriram que ele poderia gerar animações altamente convincentes com excelente sincronização labial, piscar de olhos naturais e movimentos de cabea§a coerentes com a fala.

"Nosso trabalho éum passo adiante para alcana§ar animações realistas de rostos falantes que podem se traduzir em vários aplicativos do mundo real, como assistentes digitais, dublagem de vadeo ou telepresena§a", acrescentou Bhowmick. “Em nossos pra³ximos estudos, planejamos integrar expressaµes faciais e emoções realistas ao lado de sincronização labial, piscar de olhos e movimento de cabea§a coerente com a falaâ€.