Tecnologia Científica

Um one-up na captura de movimento

uma equipe de pesquisadores do MIT e da IBM desenvolveu um pipeline de rede neural treinado que evita esse problema, com a capacidade de inferir o estado do ambiente e as aa§aµes que acontecem, as caracteristicas físicas do objeto ou pessoa...

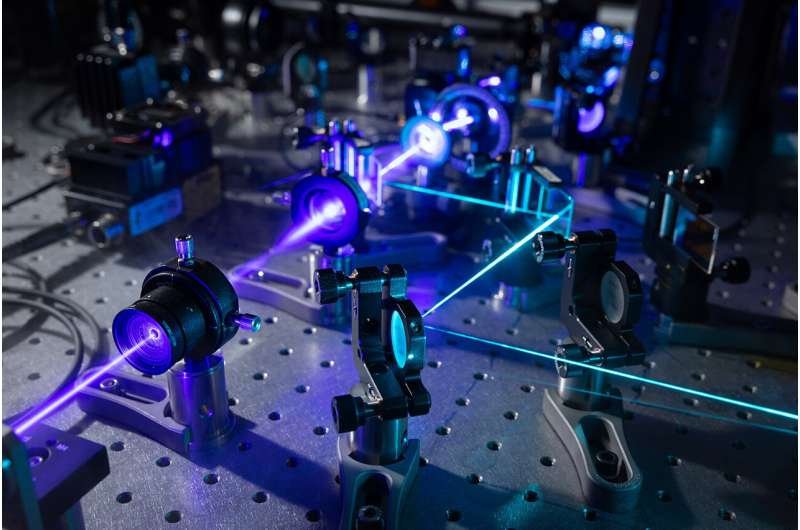

Os pesquisadores do MIT usaram o manãtodo RISP para prever a sequaªncia de ação, rigidez articular ou movimento de uma ma£o articulada, como esta, a partir de uma imagem ou vadeo alvo. Imagem cortesia dos pesquisadores

De “Star Wars†a “Happy Feetâ€, muitos filmes amados contem cenas que foram possibilitadas pela tecnologia de captura de movimento, que registra o movimento de objetos ou pessoas por meio de vadeo. Além disso, os aplicativos para esse rastreamento, que envolvem interações complicadas entre física, geometria e percepção, se estendem além de Hollywood para as forças armadas, treinamento esportivo, campos médicos e visão computacional e roba³tica, permitindo que os engenheiros entendam e simulem ações que acontecem no mundo real. ambientes.

Como esse pode ser um processo complexo e caro osmuitas vezes exigindo marcadores colocados em objetos ou pessoas e gravando a sequaªncia de ação osos pesquisadores estãotrabalhando para transferir a carga para as redes neurais, que podem adquirir esses dados de um vadeo simples e reproduzi-los em um modelo . O trabalho em simulações físicas e renderização promete tornar isso mais amplamente utilizado, uma vez que pode caracterizar movimentos realistas, contanuos e dina¢micos de imagens e transformar entre uma renderização 2D e uma cena 3D no mundo. No entanto, para isso, as técnicas atuais exigem o conhecimento preciso das condições ambientais em que a ação estãoocorrendo e a escolha do renderizador, ambos muitas vezes indisponaveis.

Agora, uma equipe de pesquisadores do MIT e da IBM desenvolveu um pipeline de rede neural treinado que evita esse problema, com a capacidade de inferir o estado do ambiente e as ações que acontecem, as caracteristicas físicas do objeto ou pessoa de interesse (sistema) , e seus parametros de controle. Quando testada, a técnica pode superar outros manãtodos em simulações de quatro sistemas fasicos de corpos ragidos e deforma¡veis, que ilustram diferentes tipos de dina¢micas e interações, sob diversas condições ambientais. Além disso, a metodologia permite o aprendizado por imitação osprevendo e reproduzindo a trajeta³ria de um quadrotor voador do mundo real a partir de um vadeo.

“O problema de pesquisa de altonívelcom o qual este artigo trata écomo reconstruir um gaªmeo digital a partir de um vadeo de um sistema dina¢micoâ€, diz Tao Du PhD '21, pa³s-doc no Departamento de Engenharia Elanãtrica e Ciência da Computação (EECS), um membro do Laborata³rio de Ciência da Computação e Inteligaªncia Artificial (CSAIL), e membro da equipe de pesquisa. Para fazer isso, diz Du, “precisamos ignorar as variações de renderização dos videoclipes e tentar entender as informações principais sobre o sistema dina¢mico ou o movimento dina¢micoâ€.

Os coautores de Du incluem o autor principal Pingchuan Ma, estudante de pós-graduação em EECS e membro do CSAIL; Josh Tenenbaum, Professor de Desenvolvimento de Carreira Paul E. Newton de Ciência Cognitiva e Computação no Departamento de Canãrebro e Ciências Cognitivas e membro do CSAIL; Wojciech Matusik, professor de engenharia elanãtrica e ciência da computação e membro do CSAIL; e Chuang Gan, principal membro da equipe de pesquisa do MIT-IBM Watson AI Lab. Este trabalho foi apresentado esta semana na Conferência Internacional sobre Representações de Aprendizagem.

Embora a captura de vadeos de personagens, robôs ou sistemas dina¢micos para inferir movimentos dina¢micos torne essas informações mais acessaveis, também traz um novo desafio. “As imagens ou vadeos [e como eles são renderizados] dependem em grande parte das condições de iluminação, das informações de fundo, das informações de textura, das informações materiais do seu ambiente e não são necessariamente mensura¡veis ​​em um mundo real. cena¡rioâ€, diz Du. Sem essas informações de configuração de renderização ou conhecimento de qual renderizador éusado, atualmente édifacil coletar informações dina¢micas e prever o comportamento do assunto do vadeo. Mesmo que o renderizador seja conhecido, as abordagens atuais de rede neural ainda exigem grandes conjuntos de dados de treinamento. No entanto, com sua nova abordagem, isso pode se tornar um ponto discutavel. “Se vocêgravar um vadeo de um leopardo correndo de manha£ e a noite, éclaro, vocêobtera¡ videoclipes visualmente diferentes porque as condições de iluminação são bem diferentes. Mas o que realmente importa éo movimento dina¢mico: os a¢ngulos das articulações do leopardo osnão se eles parecem claros ou escurosâ€, diz Du.

Para tirar os domanios de renderização e as diferenças de imagem do problema, a equipe desenvolveu um sistema de pipeline contendo uma rede neural, apelidada de rede “rendering invariant state-prediction (RISP)â€. O RISP transforma diferenças de imagens (pixels) em diferenças de estados do sistema — ou seja, o ambiente de ação — tornando seu manãtodo generaliza¡vel e agnóstico a s configurações de renderização. O RISP étreinado usando parametros e estados de renderização aleata³rios, que são alimentados em um renderizador diferencia¡vel, um tipo de renderizador que mede a sensibilidade dos pixels em relação a s configurações de renderização, por exemplo, iluminação ou cores do material. Isso gera um conjunto de imagens e vadeos variados a partir de parametros conhecidos de verdade, que mais tarde permitira£o ao RISP reverter esse processo, prevendo o estado do ambiente a partir do vadeo de entrada. A equipe também minimizou os gradientes de renderização do RISP, para que suas previsaµes fossem menos sensaveis amudanças nas configurações de renderização, permitindo que ele aprendesse a esquecer as aparaªncias visuais e se concentrar no aprendizado de estados dina¢micos. Isso épossível por um renderizador diferencia¡vel.

O manãtodo então usa dois pipelines semelhantes, executados em paralelo. Um épara o domanio de origem, com varia¡veis ​​conhecidas. Aqui, os parametros e ações do sistema são inseridos em uma simulação diferencia¡vel. Os estados da simulação gerada são combinados com diferentes configurações de renderização em um renderizador diferencia¡vel para gerar imagens, que são alimentadas no RISP. O RISP então produz previsaµes sobre os estados ambientais. Ao mesmo tempo, um pipeline de domanio de destino semelhante éexecutado com varia¡veis ​​desconhecidas. O RISP neste pipeline éalimentado com essas imagens de saada, gerando um estado previsto. Quando os estados previstos dos domanios de origem e destino são comparados, uma nova perda éproduzida; essa diferença éusada para ajustar e otimizar alguns dos parametros no pipeline do domanio de origem. Este processo pode então ser iterado,

Para determinar o sucesso de seu manãtodo, a equipe testou-o em quatro sistemas simulados: um quadrotor (um corpo ragido voador que não tem contato fasico), um cubo (um corpo ragido que interage com seu ambiente, como um dado) , uma ma£o articulada e uma haste (corpo deforma¡vel que pode se mover como uma cobra). As tarefas incluaam estimar o estado de um sistema a partir de uma imagem, identificar os parametros do sistema e os sinais de controle de ação de um vadeo e descobrir os sinais de controle de uma imagem alvo que direcionam o sistema para o estado desejado. Além disso, eles criaram linhas de base e um ora¡culo, comparando o novo processo RISP nesses sistemas com manãtodos semelhantes que, por exemplo, não possuem a perda de gradiente de renderização, não treinam uma rede neural com qualquer perda ou não possuem a rede neural RISP completamente. A equipe também analisou como a perda de gradiente afetou o desempenho do modelo de previsão de estado ao longo do tempo. Finalmente, os pesquisadores implantaram seu sistema RISP para inferir o movimento de um quadrotor do mundo real, que possui dina¢mica complexa, a partir de vadeo. Eles compararam o desempenho com outras técnicas que não tinham uma função de perda e usavam diferenças de pixel, ou uma que incluaa ajuste manual da configuração de um renderizador.

Em quase todos os experimentos, o procedimento RISP superou os manãtodos semelhantes ou de última geração disponaveis, imitando ou reproduzindo os parametros ou movimentos desejados e provando ser um concorrente eficiente e generaliza¡vel de dados para as abordagens atuais de captura de movimento.

Para este trabalho, os pesquisadores fizeram duas suposições importantes: que as informações sobre a ca¢mera sejam conhecidas, como sua posição e configurações, bem como a geometria e a física que governam o objeto ou pessoa que estãosendo rastreada. Trabalhos futuros estãoplanejados para resolver isso.

“Acho que o maior problema que estamos resolvendo aqui éreconstruir as informações de um domanio para outro, sem equipamentos muito carosâ€, diz Ma. Essa abordagem deve ser "útil para [aplicativos como o] metaverso, que visa reconstruir o mundo fasico em um ambiente virtual", acrescenta Gan. reconstrução ou o problema da dina¢mica inversaâ€, diz Ma.

Esta pesquisa foi apoiada, em parte, pelo MIT-IBM Watson AI Lab, Nexplore, programa DARPA Machine Common Sense, Office of Naval Research (ONR), ONR MURI e Mitsubishi Electric.

.jpg)