Tecnologia Científica

Peracia visual que pode detectar texto falso

Pesquisadores desenvolvem um manãtodo para identificar conteaºdo gerado por computador

Cortesia de SEAS

Em um momento de deepfakes e Inteligaªncia Artificial (AI) equipado com uma linguagem natural humana, pesquisadores da Harvard John A. Paulson School of Engineering e Applied Sciences (SEAS) e da IBM Research perguntaram: Como podemos ajudar as pessoas a detectar texto gerado por IA? ?

Essa pergunta levou Sebastian Gehrmann, um Ph.D. candidato na Escola de Graduação de Artes e Ciências, e Hendrik Strobelt, pesquisador da IBM, para desenvolver um manãtodo estatastico, juntamente com uma ferramenta interativa de acesso aberto, para diferenciar a linguagem gerada pelo ca³digo da fala humana.

Os geradores de linguagem natural são treinados em dezenas de milhões de textos online e imitam a linguagem humana, prevendo as palavras que mais frequentemente se seguem. Por exemplo, as palavras “haveâ€, “am†e “was†são estaticamente mais prova¡veis ​​depois da palavra “euâ€.

Usando essa ideia, Gehrmann e Strobelt desenvolveram um manãtodo que, em vez de sinalizar erros no texto, identifica o texto que émuito previsível.

“A ideia que tivemos foi que, a medida que os modelos se tornam melhores e melhores, eles va£o de definitivamente piores que os humanos, que são detecta¡veis, tão bons ou melhores que os humanos, que podem ser difaceis de detectar com abordagens convencionaisâ€, disse Gehrmann.

"Antes, vocêpoderia dizer por todos os erros que o texto foi gerado por ma¡quina", disse Strobelt. “Agora, não são mais os erros, mas sim o uso de palavras altamente prova¡veis ​​(e um tanto chatas) que chamam o texto gerado por ma¡quina. Com esta ferramenta, humanos e IA podem trabalhar juntos para detectar texto falso. â€

"Esta pesquisa édirecionada para dar aos humanos mais informações para que eles possam tomar uma decisão informada sobre o que éreal e o que éfalso."

- Sebastian Gehrmann

Gehrmann e Strobelt apresentara£o sua pesquisa, que foi co-autoria de Alexander Rush , um associado em ciência da computação na SEAS, na conferaªncia Association for Computational Linguistics de domingo a quinta-feira.

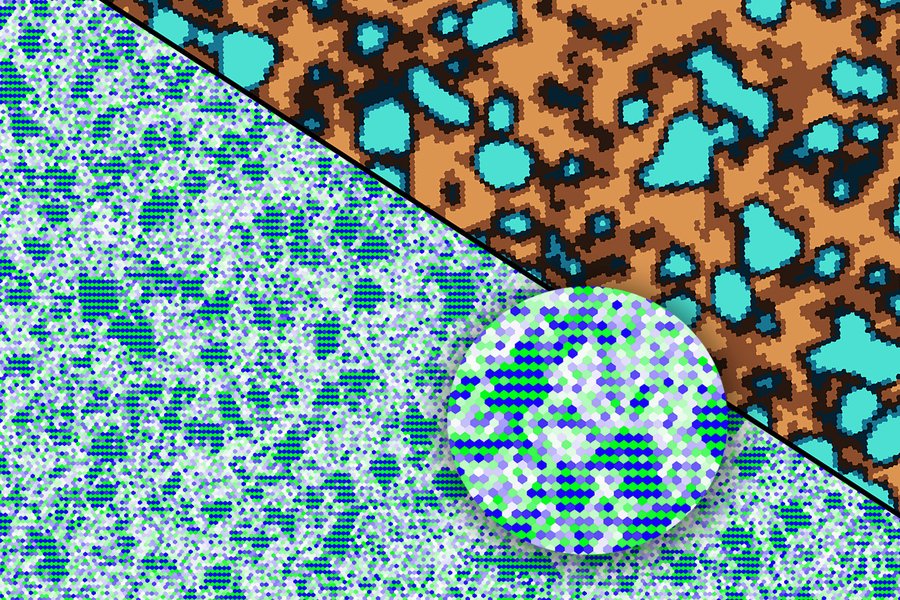

O manãtodo de Gehrmann e Strobelt, conhecido como GLTR , ébaseado em um modelo treinado em 45 milhões de textos de sites - a versão pública do modelo OpenAI, GPT-2. Como ele usa o GPT-2 para detectar o texto gerado, o GLTR funciona melhor com o GPT-2, mas também se sai bem contra outros modelos.

Veja como isso funciona:

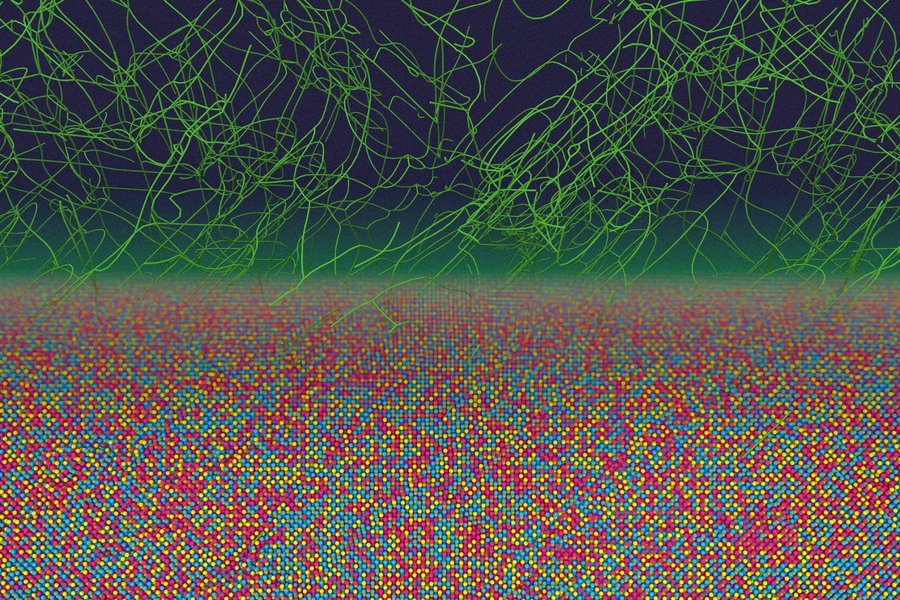

Os usuários inserem uma passagem de texto na ferramenta, que destaca cada palavra em verde, amarelo, vermelho ou roxo, cada cor significando a previsibilidade da palavra no contexto do que segue. Verde significa que a palavra era muito previsível; amarelo, moderadamente previsível; vermelho não émuito previsível; e roxo significa que o modelo não teria previsto a palavra.

Para comparar, este éum artigo real do New York Times:

E este éum excerto do texto mais imprevisível já escrito por um humano, “Finnegans Wake†de James Joyce:

O manãtodo não pretende substituir os seres humanos na identificação de textos falsos, mas para apoiar a intuição humana e a compreensão. Os pesquisadores testaram o modelo com um grupo de alunos de graduação em uma aula de ciências da computação do SEAS. Sem o modelo, os alunos poderiam identificar cerca de 50% do texto gerado pela IA. Com a sobreposição de cores, eles identificaram 72%.

Gehrmann e Strobelt dizem que com um pouco de treinamento e experiência com o programa, o percentual pode ficar ainda melhor.

"Nosso objetivo écriar sistemas de colaboração humanos e de inteligaªncia artificial", disse Gehrmann. "Esta pesquisa édirecionada para dar aos humanos mais informações para que eles possam tomar uma decisão informada sobre o que éreal e o que éfalso."